介绍

原文链接:https://kylemayes.github.io/vulkanalia/introduction.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本教程是用 Rust 对 https://vulkan-tutorial.com 的改写版本,应当归功于原教程的作者 (Alexander Overvoorde) 及其他贡献者们。

同时,本教程也包含由笔者原创的章节(从推送常量章节开始)。这些章节介绍了在几乎所有的 Vulkan 应用中都非常重要的 Vulkan 概念和特性。然而,正如这些章节中所说明的那样,这些特性是实验性的。

关于

本教程会教授一些 Vulkan 图形与计算 API 的基础知识。Vulkan 是一个由 Khronos 组织 (因 OpenGL 而为人所知)提出的新 API,针对现代显卡的特性提供了更好的抽象。新的接口可以让你更好地描述你的应用程序要做什么,从而带来相比于 OpenGL 和 Direct3D 之类的现有的图形 API 更好的性能和更少的意外驱动程序行为。Vulkan 的设计思想与 Direct3D 12 和 Metal 相似,但 Vulkan 在跨平台方面具有优势,可以让你同时开发 Windows,Linux 和 Android 应用程序(并借由 MoltenVK 开发 iOS 与 MacOS 应用程序)。

然而,为了这些增益,你所付出的代价便是你要使用一个更加冗长的 API。从创建帧缓冲(framebuffer)到管理缓冲和纹理图像一类对象的内存,每个和图形 API 相关的细节都需要在你的应用程序中从头开始设置。图形驱动程序会做更少手把手的指导,也就意味着你要在你的应用程序中做更多工作来确保正确的行为。

简而言之,Vulkan 并不是适合所有人使用的 API。它面向的是那些热衷于高性能计算机图形学,并且愿意为其投入精力的程序员们。如果你更感兴趣的是游戏开发而不是计算机图形学,那么你可能还是应该坚持使用 OpenGL 或者 Direct3D,因为它们不会那么快被 Vulkan 取代。另一个选择是使用像 Unreal Engine 这样的引擎,它们可以使用 Vulkan,但会提供给你一个更高层次的 API。

抛开上面的问题,让我们来看看跟着这个教程学习所需的一些东西:

本教程不会要求你有 OpenGL 或者 Direct3D 的知识储备,但要求你必须理解 3D 计算机图形学的基础。例如,教程中不会解释透视投影背后的数学原理。这本在线书籍是一个很好的计算机图形学入门资源。其他一些很好的计算机图形学资源包括:

- Ray tracing in one weekend

- Physically Based Rendering book

- 在真正的开源游戏引擎中使用 Vulkan:Quake 和 DOOM 3

如果你想要 C++ 教程,请查看原教程:

https://vulkan-tutorial.com

本教程使用 vulkanalia crate 来提供 Rust 语言对 Vulkan API 的访问。vulkanalia 提供了对 Vulkan API 的原始绑定,同时也提供了一个轻量级的封装,使得运用这些 API 更简单,也“更 Rust”(下一章里你会看到的)。也就是说,你不必费心考虑你的 Rust 程序如何与 Vulkan API 交互,同时你也能免受 Vulkan API 的危险性和冗长性的影响。

如果你想要一个使用更安全、细致封装的 vulkano crate 的 Rust Vulkan 教程,请查看这个教程:https://github.com/bwasty/vulkan-tutorial-rs。

教程结构

我们首先会速览一下 Vulkan 是如何工作的,以及要把第一个三角形画到屏幕上所需的工作。在你了解这些小的步骤在整个过程中的基本作用之后,它们的目的会更加清晰。接下来,我们会使用 Vulkan SDK 来设置开发环境。

在这之后,我们会实现渲染第一个三角形的 Vulkan 程序所需的所有基本组件。每一章的结构大致如下:

- 引入一个新的概念及其目的

- 使用所有相关的 API 调用,将其集成到你的程序中

- 将其抽象为辅助函数

尽管每一章都是作为前一章的后续章节编写的,但把每一章作为单独的介绍一个特定 Vulkan 特性的文章来阅读也是可以的。也就是说这个网站也可以作为一个 Vulkan 参考。所有 Vulkan 函数和类型都链接到了 Vulkan 规范或者 vulkanalia 的文档,你可以点击链接来了解更多。Vulkan 仍然是一个非常年轻的 API,所以 Vulkan 的规范本身可能有一些缺点。你可以提交反馈到 这个 Khronos 仓库。

如同前面所提到的,Vulkan API 是一个非常冗长的 API,提供了许多参数,能给你对图形硬件最大的控制。这就导致像创建纹理这种基本操作都要经过很多步骤,而且每次都要重复。因此,我们会在整个教程中会创建一系列我们自己的的辅助函数。

每一章也包含了一个链接,指向了该章节完成后的最终代码。如果你对代码的结构有任何疑问,或者你遇到了 bug,想要对比一下,你可以参考这些代码。

本教程旨在成为社区的共同努力。Vulkan 仍然是一个相当新的 API,而最佳实践尚未完全建立。如果你对教程或者网站本身有任何类型的反馈,请随时向 GitHub 存储库 提交问题或拉取请求。

译者注:本译本也有 GitHub 仓库,如果你对中文翻译有任何疑问或者改进建议,欢迎提交 Issue 和 PR :)

在你完成了第一个 Vulkan 三角形的绘制之后,我们会开始扩展程序,添加线性变换、纹理和 3D 模型等功能。

如果你有使用其他图形 API 的经验,你会明白在第一个三角形在屏幕上显示出来之前可能会有很多步骤。在 Vulkan 中也有很多这样的步骤,但是你会发现每个步骤都很容易理解,而且不会感觉哪一步是多余的。一旦你有了这个基础的三角形,绘制拥有贴图的 3D 模型并不需要太多额外的工作,并且在这之后的每一步都会给你带来更多增益。

如果你在阅读本教程时遇到了任何问题,请查阅 FAQ,看看你的问题和解决方案是否已经在里面列出。接下来,你可以在原教程对应章节的评论区里找找,看是否有人遇到了相同的问题(如果不是 Rust 特有的问题)。

概览

原文链接:https://kylemayes.github.io/vulkanalia/overview.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章会以介绍 Vulkan 和它所解决的问题开始。之后,我们会看到绘制第一个三角形所需的所有组件。这会给你一个总体的蓝图,以便你将每个后续章节放在正确的位置。之后我们会讨论 vulkanalia 提供的 Vulkan API。

Vulkan 的起源

和之前的图形 API 一样,Vulkan 也是为跨平台抽象 GPU 而设计的。以往的 API 大都有一个问题,那就是它们都是根据诞生年代的图形硬件特性来设计的,而此时的图形硬件大多都只有一些可配置的功能。程序员必须以标准的格式提供顶点数据,并且在光照和着色选项上受制于 GPU 制造商。

在显卡架构成熟之后,它们开始提供更多的可编程特性。所有这些新功能都必须以某种方式与现有的 API 集成。这就导致这些 API 不能提供理想的抽象,而显卡驱动需要猜测程序员的意图,以将其映射到现代图形架构。这就是为什么有这么多驱动更新来提高游戏性能,而且有时候提升幅度很大。由于这些驱动的复杂性,应用程序开发人员还需要处理制造商之间的不一致性,例如着色器接受的语法。除了这些新功能之外,过去十年还涌入了具有强大图形硬件的移动设备。这些移动 GPU 出于空间和能耗上的考虑采用了与桌面端不同的架构。其中一个例子是 tiled rendering,它可以给程序员提供对此功能的更多控制,从而提高性能。此外受限于诞生的年代,这些 API 对多线程的支持都非常有限,这可能会导致 CPU 成为性能瓶颈。

Vulkan 从头开始、针对现代图形架构而设计,从而解决了上述问题。Vulkan 要求程序员明确地指定他们的意图,从而减少驱动开销,并允许多个线程并行创建和提交指令。Vulkan 使用一种标准的字节码格式和一种编译器来减少着色器编译中的不一致性。最后,它将现代图形卡的通用处理能力纳入到单个 API 中,从而将图形和计算功能统一起来。

画一个三角形需要什么

接下来我们会总览一下在一个良好的 Vulkan 程序中绘制一个三角形所需的所有步骤。这里只是给你一个大的蓝图,以便你将所有的单独组件联系起来,而所有概念都会在后面的章节中详细介绍。

1. 创建实例并选择物理设备

一个 Vulkan 应用首先通过创建一个 VkInstance 来设置 Vulkan API。实例的创建是通过描述你的应用程序和你将要使用的 API 扩展来完成的。创建实例之后,你可以查询支持 Vulkan 的硬件,并选择一个或多个 VkPhysicalDevice 来使用。你可以查询像 VRAM 大小和设备功能这样的属性来选择所需的设备,例如优先使用独立显卡。

2. 逻辑设备和队列族(queue families)

选择正确的硬件设备后,你需要创建一个 VkDevice (逻辑设备),在这里你需要更具体地描述你将要使用的 VkPhysicalDeviceFeatures,例如多视口渲染和 64 位浮点数。你还需要指定你想要使用的队列族。大多数 Vulkan 操作,例如绘制指令和内存操作,都是通过提交到 VkQueue 来异步执行的。队列是从队列族中分配的,每个队列族都支持一组特定的操作。例如,可能会有单独的队列族用于图形、计算和内存传输操作。队列族的可用性也可以用作物理设备选择的区分因素。虽然支持 Vulkan 的设备可能不提供任何图形功能,但是今天所有支持 Vulkan 的显卡通常都支持我们感兴趣的所有队列操作。

3. 创建窗口和交换链(swapchain)

除非你只对离屏渲染有兴趣,否则你需要创建一个窗口来呈现渲染图像。窗口可以使用本地平台 API 创建,也可以使用类似 GLFW、SDL 或 winit crate 的库来创建。在本教程中我们会使用 winit crate,下一章会对其进行详细介绍。

我们还需要两个组件才能完成窗口渲染:一个窗口表面(VkSurfaceKHR)和一个交换链(VkSwapchainKHR),可以注意到这两个组件都有一个 KHR 后缀,这表示它们都是 Vulkan 扩展。Vulkan 本身完全是平台无关的,这就是为什么我们需要使用标准 WSI(Window System Interface,窗口系统接口)扩展与原生的窗口管理器进行交互。表面(Surface)是一个渲染窗口的跨平台抽象,通常它是由原生窗口系统句柄 —— 例如 Windows 上的 HWND —— 作为参数实例化得到的。vulkanalia 包含了可选的 winit 集成,这会帮助我们处理创建窗口和与之关联的表面的过程中那些平台特定的细节。

交换链是一系列的渲染目标。它可以保证我们正在渲染的图像不是当前屏幕上正在显然的图像,从而确保只有完整的图像才会被显示。每次我们想要绘制一帧时,我们都必须要求交换链提供一个图像来进行渲染。当我们完成一帧的绘制后,图像就会被返回到交换链中,以便在某个时刻呈现到屏幕上。渲染目标的数量和呈现图像到屏幕的条件取决于呈现模式(present mode)。常见的呈现模式有双缓冲(垂直同步)和三缓冲。我们将在创建交换链章节讨论这些问题。

有的平台允许你直接渲染到输出,而不通过 VK_KHR_display 和 VK_KHR_display_swapchain 与窗口管理器进行交互。这就允许你创建一个覆盖整个屏幕的表面,你可以用它来实现你自己的窗口管理器。

4. 图像视图(image view)和帧缓冲(framebuffer)

从交换链获取图像后,还不能直接在图像上进行绘制,需要将图像先包装进 VkImageView 和 VkFramebuffer。一个图像视图可以引用图像的一个特定部分,而一个帧缓冲则可以引用用于颜色、深度和模板的图像视图。因为交换链中可能有很多不同的图像,所以我们会预先为每个交换链图像创建一个图像视图和帧缓冲,并在绘制时选择正确的那个。

5. 渲染流程(render passes)

Vulkan 中的渲染流程描述了渲染操作中使用的图像类型、图像的使用方式,以及如何处理它们的内容。在我们最初的三角形渲染程序中,我们会告诉 Vulkan 我们会使用一个图像作为颜色目标,并且我们希望在绘制操作之前将其清除为一个纯色。渲染流程只描述图像的类型,VkFramebuffer 则会将特定的图像绑定到这些槽中。

6. 图形管线(graphics pipeline)

Vulkan 的图形管线通过创建 VkPipeline 对象建立。它描述了显卡的可配置状态 —— 例如视口(viewport)的大小和深度缓冲操作,以及使用 VkShaderModule 的可编程状态。VkShaderModule 对象是从着色器字节码创建的。驱动还需要知道在管线中将使用哪些渲染目标,我们通过引用渲染流程来指定。

Vulkan 与之前的图形 API 最大的不同是几乎所有图形管线的配置都需要提前完成。这也就意味着如果我们想要切换到另一个着色器,或者稍微改变顶点布局,那么整个图形管线都要被重建。也就是说,我们需要为所有不同的组合创建很多 VkPipeline 对象。只有一些基本的配置 —— 例如视口大小和清除颜色 —— 可以被动态地改变。所有的状态都需要被显式地描述,没有默认的颜色混合状态。

这样做的好处类似于预编译相比于即时编译,驱动程序可以获得更大的优化空间,并且运行时的性能更加可预测,因为像切换到另一个图形管线这样的大的状态改变都是显式的。

7. 指令池和指令缓冲

之前提到,Vulkan 的许多操作 —— 例如绘制操作 —— 需要被提交到队列才能执行。这些操作首先要被记录到一个 VkCommandBuffer 中,然后提交给队列。这些指令缓冲由 VkCommandPool 分配,它与特定的队列族相关联。要绘制一个简单的三角形,我们需要记录下列操作到 VkCommandBuffer 中:

- 开始渲染

- 绑定图形管线

- 绘制三个顶点

- 结束渲染

帧缓冲绑定的图像依赖于交换链给我们的图像,我们可以提前为每个图像创建指令缓冲,然后在绘制时直接选择对应的指令缓冲使用。当然,每一帧都重新记录指令缓冲也是可以的,但这样做的效率很低。

8. 主循环

将绘制指令包装进指令缓冲之后,主循环就很直截了当了。我们首先使用 vkAcquireNextImageKHR 从交换链获取一张图像,接着为图像选择正确的指令缓冲,然后用 vkQueueSubmit 执行它。最后,我们使用 vkQueuePresentKHR 将图像返回到交换链,从而使其呈现到屏幕上。

提交给队列的操作会被异步执行。我们需要采取诸如信号量一类的同步措施来确保正确的执行顺序。绘制指令必须在获取图像完成后才能开始执行,否则可能会出现我们渲染到一个仍然在屏幕上显示的图像的情况。vkQueuePresentKHR 调用也需要等到渲染完成后才能执行,我们会使用第二个信号量来实现这一点。

总结

这个快速的介绍应该能让你对绘制第一个三角形所需的工作有一个基本的了解。一个真实的程序包含更多的步骤,例如分配顶点缓冲、创建 uniform 缓冲和上传纹理图像,这些都会在后续章节中介绍,但我们会从简单的开始,因为 Vulkan 本身的学习曲线就已经非常陡峭了。请注意,我们会通过将顶点坐标嵌入到顶点着色器中来作弊,而不使用顶点缓冲。这是因为管理顶点缓冲需要对指令缓冲有一定的了解。

所以简单来说,要绘制第一个三角形,我们需要:

- 创建一个

VkInstance - 选择一个支持的显卡(

VkPhysicalDevice) - 创建用于绘制和呈现的

VkDevice和VkQueue - 创建窗口、窗口表面和交换链

- 将交换链图像包装进

VkImageView - 创建描述渲染目标和用途的渲染流程

- 为渲染流程创建帧缓冲

- 设置图形管线

- 为每个可能的交换链图像分配并记录一个包含绘制指令的指令缓冲

- 通过获取图像、提交正确的绘制指令缓冲,然后将图像返回到交换链来绘制帧

步骤非常多,但其实每一步都非常简单。每一步都会在后续章节中详细介绍。如果你对程序中的某一步感到困惑,可以回来参考一下本章节。

API 概念

Vulkan API 是用 C 语言定义的。Vulkan API 的规范 —— Vulkan API 注册表 —— 是用一个 XML 文件来定义的,它提供了机器可读的 Vulkan API 定义。

Vulkan 头文件 是 Vulkan SDK 的一部分,它们是从 Vulkan API 注册表生成的。下一章里我们将要安装的 Vulkan SDK 包含了这些头文件。然而,我们不会直接或间接地使用这些头文件,因为 vulkanalia 提供的 Rust 接口独立于 Vulkan SDK 提供的 C 接口,这个 Rust 接口也是从 Vulkan API 注册表生成的。

vulkanalia 的基础是 vulkanalia-sys crate,它定义了 Vulkan API 注册表中的原始类型。这些原始类型被 vulkanalia crate 在 vk 模块中重新导出,同时还包含了从 Vulkan API 注册表生成的其他一些项目,作为前面介绍中提到的对 Vulkan API 的轻量级包装。

类型名称

因为 Rust 有对名称空间(namespace)的支持而 C 没有,vulkanalia 的 API 会略去 Vulkan 类型名称中用于名称空间的部分。更具体地说,Vulkan 类型,例如结构体、联合和枚举,没有 Vk 前缀。例如,VkInstanceCreateInfo 结构体在 vulkanalia 中变成了 InstanceCreateInfo 结构体,并且可以在前面提到的 vk 模块中找到。

从现在开始,本教程将使用 vulkanalia 中的 vk:: 模块前缀来引用 vulkanalia 中定义的 Vulkan 类型,以明确该类型表示的是从 Vulkan API 注册表生成的东西。

这些类型名称会被链接到 vulkanalia 文档中对应的类型。Vulkan 类型的 vulkanalia 文档还包含一个指向 Vulkan规范中该类型的链接,可以用来了解该类型的目的和用法。

一些类型名的例子:

vk::Instancevk::InstanceCreateInfovk::InstanceCreateFlags

枚举

vulkanalia 将 Vulkan 枚举实现为结构体,并将枚举变体实现为这些结构体的关联常量。不使用 Rust 枚举是因为在 FFI 调用中使用 Rust 枚举可能导致未定义行为。

因为结构体充当了关联常量的名称空间,我们也就不必像在 C 语言中那样担心不同 Vulkan 枚举(或来自其他库的枚举)名称之间的冲突。所以和类型名称一样,vulkanalia 会略去 Vulkan 枚举名称中用于名称空间的部分。

例如,VK_OBJECT_TYPE_INSTANCE 枚举变体是 VkObjectType 枚举的 INSTANCE 值。在 vulkanalia 中,这个变体变成了 vk::ObjectType::INSTANCE。

掩码(bitmasks)

vulkanalia 将掩码实现为结构体,并将位标志(bitflags)实现为这些结构体的关联常量。这些结构体和关联常量是通过 bitflags crate 提供的 bitflags! 宏来生成的。

和枚举变体一样,位标志名中用于名称空间的部分会被略去。

例如,VK_BUFFER_USAGE_TRANSFER_SRC_BIT 位标志是 VkBufferUsageFlags 掩码的 TRANSFER_SRC 位标志。在 vulkanalia 中,这个位标志变成了 vk::BufferUsageFlags::TRANSFER_SRC。

指令(command,即 Vulkan API 函数)

尽管 Vulkan specification 会将 Vulkan API 中的函数称作指令(command),但 C++ 版本的教程并没有使用这个术语。此外,将这些函数称作“指令”可能会和另一个概念引起混淆。因此本翻译中都不使用这个术语。

诸如 vkCreateInstance 的原始 Vulkan 函数的类型在 vulkanalia 中被定义为带有 PFN_(pointer to function,函数指针)前缀的函数指针类型别名。所以 vkCreateInstance 的 vulkanalia 类型别名是 vk::PFN_vkCreateInstance。

只有这些函数签名还不足以调用 Vulkan 函数,我们必须先加载这些类型所描述的函数。Vulkan 规范针对这个问题有一个详细的描述,但是在这里我会给出一个简化的版本。

第一个要加载的函数是 vkGetInstanceProcAddr,这个函数是以平台特定的方式加载的,但是 vulkanalia 提供了一个可选的 libloading 集成,我们会在本教程中使用它来从 Vulkan 共享库中加载这个函数。vkGetInstanceProcAddr 可以用来加载我们想要调用的其他 Vulkan 函数。

然而,取决于系统上的 Vulkan 实现,可能会有多个版本的 Vulkan 函数可用。例如,如果你的系统上有一个独立的 NVIDIA GPU 和一个集成的 Intel GPU,那么可能会有针对每个设备的专用 Vulkan 函数的不同实现,例如 allocate_memory。在这种情况下,vkGetInstanceProcAddr 会返回一个函数,这个函数会根据使用的设备来分派调用到正确的设备特定函数。

要避免这种分派的运行时开销,可以使用 vkGetDeviceProcAddr 函数来直接加载这些设备特定的 Vulkan 函数。这个函数的加载方式和 vkGetInstanceProcAddr 一样。

我们会在这个教程中用到许多 Vulkan 函数。幸运的是,我们不需要手动加载它们,因为 vulkanalia 已经提供了以下四类结构体,可以用来轻松地加载所有 Vulkan 函数:

vk::StaticCommands– 以平台特定的方式加载的 Vulkan 函数,可以用来加载其他函数(例如vkGetInstanceProcAddr和vkGetDeviceProcAddr)vk::EntryCommands– 使用vkGetInstanceProcAddr和一个空的 Vulkan 实例加载的 Vulkan 函数。这些函数不与特定的 Vulkan 实例绑定,可以用来查询实例支持并创建实例vk::InstanceCommands– 使用vkGetInstanceProcAddr和一个有效的 Vulkan 实例加载的 Vulkan 函数。这些函数与特定的 Vulkan 实例绑定,可以用来查询设备支持并创建设备vk::DeviceCommands– 使用vkGetDeviceProcAddr和一个有效的 Vulkan 设备加载的 Vulkan 函数。这些函数与特定的 Vulkan 设备绑定,并且提供了你期望中图形 API 提供的大多数功能

这些结构体能让你简单地在 Rust 中加载和调用原始 Vulkan 函数,不过 vulkanalia 提供了对原始函数的包装,这使得在 Rust 中使用它们更加容易,并且不易出错。

函数封装(command wrapper)

一个典型的 Vulkan 函数的签名在 C 中看起来就像这样:

VkResult vkEnumerateInstanceExtensionProperties(

const char* pLayerName,

uint32_t* pPropertyCount,

VkExtensionProperties* pProperties

);

熟悉 Vulkan API 的人可以从这个签名中快速看出这个函数的用法,尽管它没有包含一些关键信息。

而对于那些刚接触 Vulkan API 的人来说,查看此函数的文档可能会更有启发性。文档中对此函数行为的描述表明,使用此函数列出 Vulkan 实例可用的扩展(extension)需要多个步骤:

- 调用函数以获取扩展的数量

- 分配一个可以容纳输出的缓冲

- 再次调用函数,获取扩展并填充缓冲

所以在 C++ 中,这些步骤可能看起来像这样(简单起见,这里忽略了函数的结果):

// 1.

uint32_t pPropertyCount;

vkEnumerateInstanceExtensionProperties(NULL, &pPropertyCount, NULL);

// 2.

std::vector<VkExtensionProperties> pProperties{pPropertyCount};

// 3.

vkEnumerateInstanceExtensionProperties(NULL, &pPropertyCount, pProperties.data());

而 vkEnumerateInstanceExtensionProperties 的封装的 Rust 签名如下:

unsafe fn enumerate_instance_extension_properties(

&self,

layer_name: Option<&[u8]>,

) -> VkResult<Vec<ExtensionProperties>>;这个函数封装使得从 Rust 使用 vkEnumerateInstanceExtensionProperties 更加容易、更少出错,并且更符合习惯用法:

layer_name参数的可选性被编码在函数签名中。这个参数是可选的,这一点在 C 函数签名中没有体现,需要查阅 Vulkan 规范才能得到这个信息- 函数的可失败性通过返回一个

Result(VkResult<T>是Result<T, vk::ErrorCode>的类型别名)体现。这使得我们可以利用 Rust 强大的错误处理能力,并且在我们忘记检查可失败函数的结果时,编译器会发出警告 - 函数封装在内部处理了上面描述的三个步骤,并返回一个包含扩展属性的

Vec

注意,函数封装仍然是 unsafe 的,因为虽然 vulkanalia 可以消除某些类型的错误(例如给此函数传递一个空的层名称),但还是有很多可能会出错的事情,导致诸如段错误之类“有趣”的事情发生。你可以随时检查 Vulkan 文档中函数的 Valid Usage 部分以了解如何正确地调用函数。

你可能注意到了上面函数封装中的 &self 参数。这些函数封装是在 trait 中定义的,而 vulkanalia 暴露的类型实现了这些 trait。这些 trait 可以分为两类:版本 trait(version traits)和扩展 trait(extension traits)。版本 trait 为 Vulkan 的标准部分中的函数提供函数封装,而扩展 trait 为 Vulkan 扩展中的函数提供函数封装。

例如,enumerate_instance_extension_properties 是一个非扩展 Vulkan 函数,是 Vulkan 1.0 的一部分,不依赖于 Vulkan 实例或设备,所以它被放在 vk::EntryV1_0 trait 中。而 cmd_draw_indirect_count 函数是在 Vulkan 1.2 中添加的,并且依赖于 Vulkan 设备,所以它被放在 vk::DeviceV1_2 trait 中。

而 vk::KhrSurfaceExtension 是一个扩展 trait,我们将在后面的章节中使用它来调用 destroy_surface_khr 这样的 Vulkan 函数,这些函数是在 VK_KHR_surface 扩展中定义的。

这些版本和扩展 trait 是为包含加载的函数和所需的 Vulkan 实例或设备(如果有的话)的类型定义的。这些类型是精心手工制作的,而不是 vulkanalia 的 vk 模块中自动生成的 Vulkan 绑定的一部分。它们是 Entry、Instance 和 Device 结构体,将在后面的章节中使用。

从现在开始,本教程将继续像本章节一样直接按名称引用这些函数封装(例如 create_instance)。你可以访问 vulkanalia 文档来获取函数封装的更多信息,例如函数封装是在哪个 trait 中定义的。

生成器(Builders)

Vulkan API 通常使用结构体作为 Vulkan 函数的参数。这些作为函数的参数使用的 Vulkan 结构体有一个字段,用于指示结构体的类型。在 C API 中,这个字段(sType)需要被显式地设置。例如,这里我们正在填充 VkInstanceCreateInfo 的一个实例,然后在 C++ 中使用它来调用 vkCreateInstance:

std::vector<const char*> extensions{/* 3 extension names */};

VkInstanceCreateInfo info;

info.sType = VK_STRUCTURE_TYPE_INSTANCE_CREATE_INFO;

info.enabledExtensionCount = static_cast<uint32_t>(extensions.size());

info.ppEnabledExtensionNames = extensions.data();

VkInstance instance;

vkCreateInstance(&info, NULL, &instance);

当使用 vulkanalia 时,你仍然可以用这种方式填充参数结构体,但是 vulkanalia 提供了生成器(builder),简化了这些参数结构体的构造。在 vulkanalia 中,vk::InstanceCreateInfo 对应的生成器是 vk::InstanceCreateInfoBuilder。使用这个生成器,上面的代码就可以写成:

let extensions = &[/* 3 extension names */];

let info = vk::InstanceCreateInfo::builder()

.enabled_extension_names(extensions)

.build();

let instance = entry.create_instance(&info, None).unwrap();注意以下差异:

- 无需为

s_type字段提供值。这是因为生成器会自动为这个字段提供正确的值(vk::StructureType::INSTANCE_CREATE_INFO) - 无需为

enabled_extension_count字段提供值。这是因为生成器的enabled_extension_names方法会自动使用提供的切片的长度设置这个字段

然而,上面的 Rust 代码有一定程度的危险。生成器有生存期(lifetime),这要求生成器中存储的引用至少要与生成器本身活得一样久。也就是说,在上面的例子中,Rust 编译器会确保传递给 enabled_extension_names 方法的切片至少活得与生成器一样长。然而,一旦我们调用 .build() 来获取底层的 vk::InstanceCreateInfo 结构体,生成器的生存期就会被丢弃。这意味着 Rust 编译器不再能防止我们 搬起石头砸自己的脚,例如解引用一个已经不存在的切片的指针。

下面的代码会崩溃(但愿如此),因为传递给 enabled_extension_names 的临时 Vec 在我们使用 vk::InstanceCreateInfo 结构体调用 create_instance 时已经被销毁了:

let info = vk::InstanceCreateInfo::builder()

.enabled_extension_names(&vec![/* 3 extension names */])

.build();

let instance = entry.create_instance(&info, None).unwrap();幸运的是,vulkanalia 为此提供了解决方案 —— 不调用 build(),而是直接将生成器传递给函数封装!在任何接受 Vulkan 结构体的地方,你都可以直接提供与 Vulkan 结构体对应的生成器。如果从上面的代码中删除 build() 调用,Rust 编译器就能够利用生成器上的生存期来拒绝这个坏代码,并告诉你 error[E0716]: temporary value dropped while borrowed。

prelude 模块

vulkanalia 提供了prelude 模块,用于暴露使用 crate 所需的基本类型。每个 Vulkan 版本都有一个 prelude 模块,每个模块都会暴露相关的函数 trait,以及其他经常用到的类型:

// Vulkan 1.0

use vulkanalia::prelude::v1_0::*;

// Vulkan 1.1

use vulkanalia::prelude::v1_1::*;

// Vulkan 1.2

use vulkanalia::prelude::v1_2::*;校验层(Validation layers)

如前文所述,Vulkan 是为高性能和低驱动程序开销而设计的。因此,默认情况下 Vulkan 只包含非常有限的错误检查和调试功能。如果你做错了什么,驱动程序通常会崩溃而不是返回错误代码,或者比这更糟 —— 程序会在你的显卡上运行,但在其他显卡上完全失效。

你可以通过校验层来在 Vulkan 中启用很多检查。校验层是可以插入到 API 和图形驱动程序之间的代码片段,用于对函数参数进行额外的检查,并且跟踪内存管理问题。你可以在开发时启用它们,然后在发布应用程序时将其完全禁用,从而实现零开销。任何人都可以编写自己的校验层,但是 LunarG 的 Vulkan SDK 提供了一套标准的校验层,我们将在本教程中使用它们。你还需要注册一个回调函数来接收校验层的调试消息。

因为 Vulkan 对每个操作都非常明确,校验层也非常广泛,所以实际上相比于 OpenGL 和 Direct3D,你更容易找出为什么你的画面是全黑的!

开发环境

原文链接:https://kylemayes.github.io/vulkanalia/development_environment.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

在这个章节中,我们将会安装 Vulkan SDK 并搭建开发 Vulkan 应用所需的环境。此教程假设你已经有一个搭建好的 Rust(1.70+)开发环境。

Cargo 项目

首先,我们创建一个 Cargo 项目:

cargo new vulkan-tutorial

在执行这个命令后,你会看到一个叫做 vulkan-tutorial 的文件夹,里面有一个简单的生成 Rust 可执行文件的 Cargo 项目。

打开这个文件夹里的 Cargo.toml 文件,并且将下列依赖加入其中的 [dependencies] 部分:

anyhow = "1"

log = "0.4"

cgmath = "0.18"

nalgebra-glm = "0.18"

png = "0.17"

pretty_env_logger = "0.5"

thiserror = "1"

tobj = { version = "3", features = ["log"] }

vulkanalia = { version = "=0.25.0", features = ["libloading", "provisional", "window"] }

winit = "0.29"

anyhow– 用于简单的错误处理log– 日志库cgmath– 一个 Rust 语言的 GLM(graphics math library,图形数学库)替代png– 用于将 PNG 图片文件加载到纹理pretty_env_logger– 用于打印日志到控制台thiserror– 用于在自定义错误类型时减少样板代码tobj– 用于加载 Wavefront .obj 格式 的 3D 模型vulkanalia– 用于调用 Vulkan APIwinit– 用于创建将进行渲染的窗口

Vulkan SDK

在开发 Vulkan 应用时需要用到的最关键的组件就是 Vulkan SDK。它包含了头文件、标准校验层、调试工具,以及一个 Vulkan 函数加载器。加载器将会在运行时从驱动中寻找 Vulkan 函数,如果你熟悉 OpenGL 的话,它的功能与 GLEW 类似。

Windows

SDK 能在 LunarG 网站下载。创建账户不是必须的,但它会给你阅读一些额外文档的权限,这些文档或许对你有用。

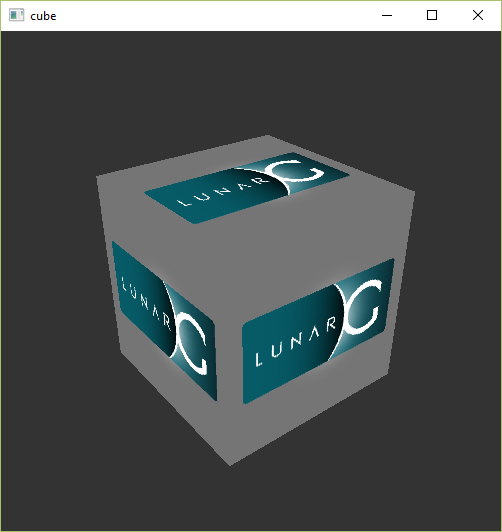

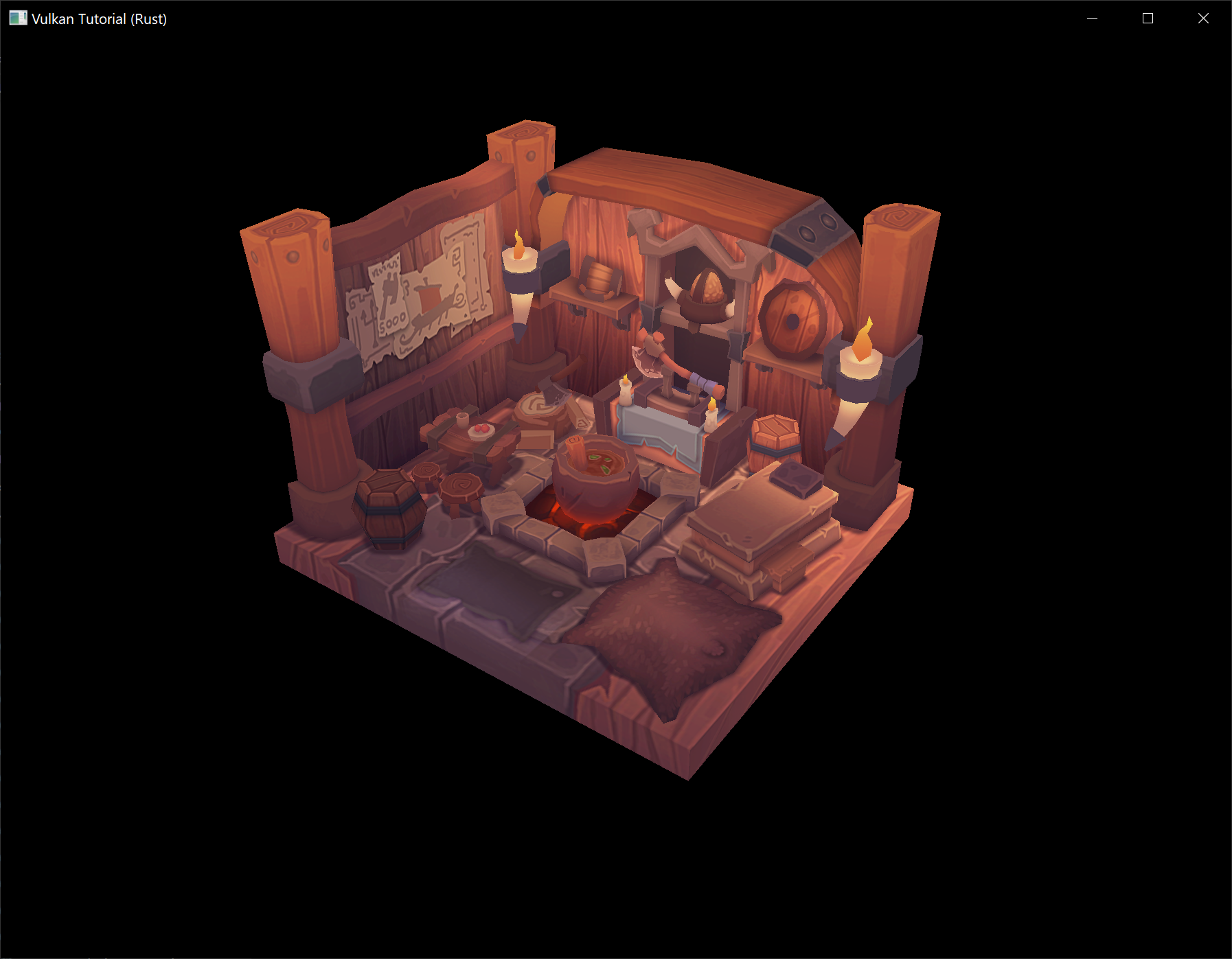

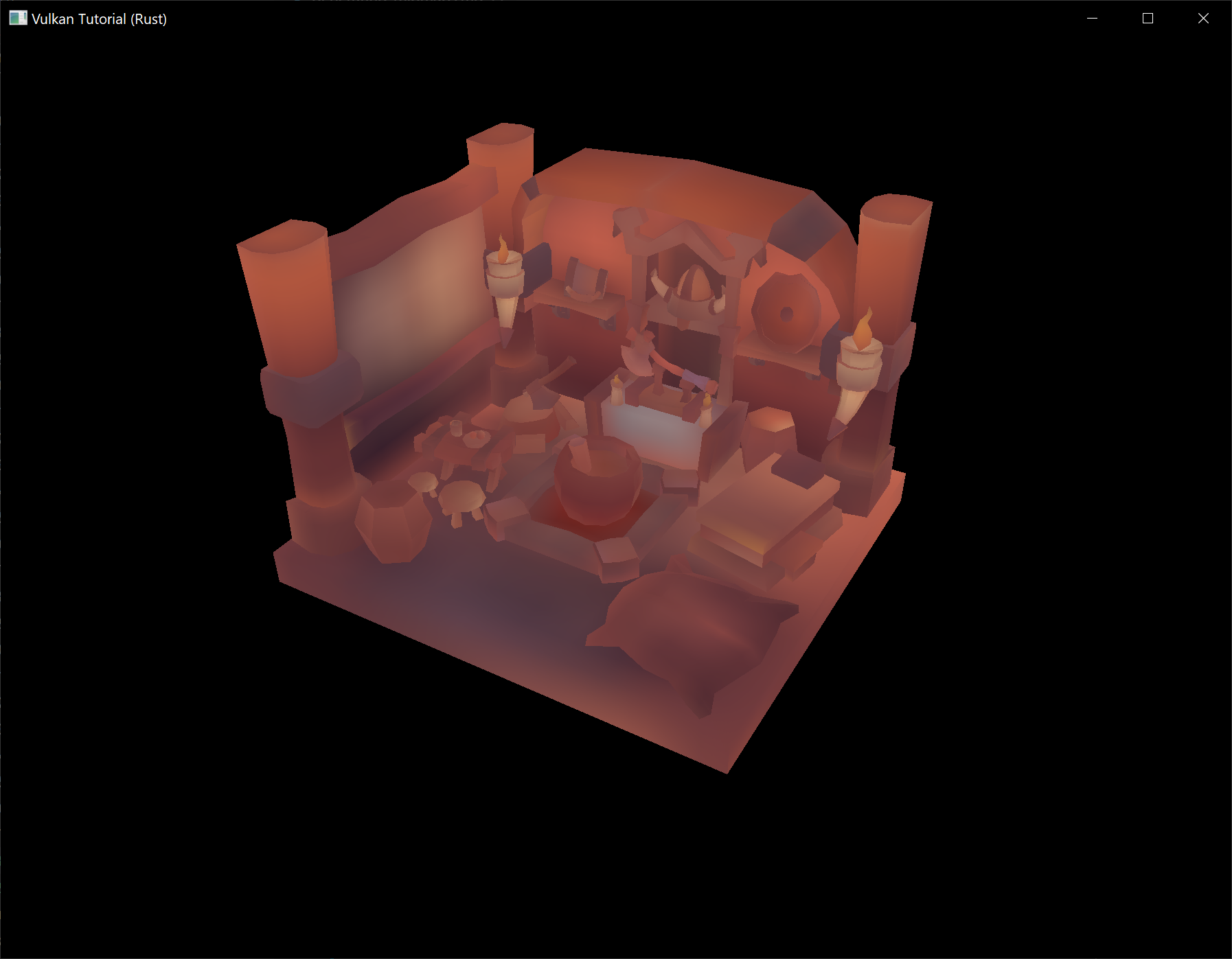

继续完成安装,并且注意 SDK 的安装路径。我们需要做的第一件事就是验证你的显卡与驱动支持 Vulkan。进入 SDK 的安装路径,打开 Bin 文件夹并且运行 vkcube.exe 示例应用。你应该会看到这个画面:

如果你收到了一条错误信息,那你需要确保你的显卡驱动是最新的,包含 Vulkan 运行时,并且你的显卡支持 Vulkan。主流品牌的驱动下载链接详见介绍章节。

这个文件夹里有另外两个对开发很有用的程序。glslangValidator.exe 和 glslc.exe 将会把人类可阅读的 GLSL (OpenGL Shading Language,OpenGL 着色器语言)代码编译为字节码。我们将会在着色器模块章节深入讨论这部分内容。Bin 文件夹也包含了 Vulkan 加载器与校验层的二进制文件;Lib 文件夹则包含了库。

你可以自由地探索其它文件,但本教程并不会用到它们。

Linux

以下操作说明面向 Ubuntu 用户,非 Ubuntu 用户也可以将 apt 命令换成合适的你使用的包管理器的命令。

在 Linux 上开发 Vulkan 应用时需要用到的最关键的组件是 Vulkan 加载器,校验层,以及一些用来测试你的机器是否支持 Vulkan 的命令行实用工具:

sudo apt install vulkan-tools– 命令行实用工具,最关键的两个是vulkaninfo和vkcube。运行这两个命令来测试你的机器是否支持 Vulkan。sudo apt install libvulkan-dev– 安装 Vulkan 加载器。加载器将会在运行时从驱动中寻找这些函数,如果你熟悉 OpenGL 的话,它的功能与 GLEW 类似。sudo apt install vulkan-validationlayers-dev– 安装标准校验层。这在调试 Vulkan 应用程序时非常关键,我们会在之后的章节中讨论这部分内容。

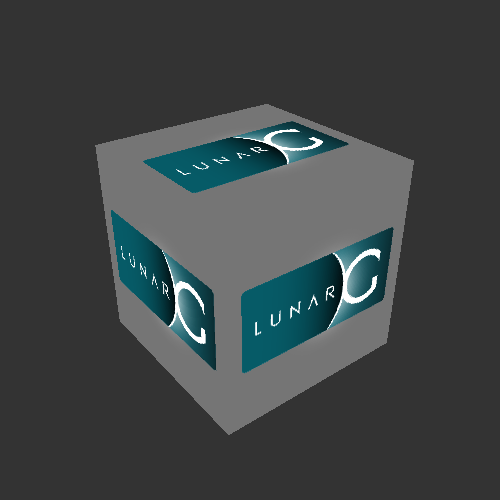

如果你安装成功了,你在 Vulkan 部分没有别的需要做的了。记得运行 vkcube 并确保你可以在一个窗口中看见这个画面:

如果你收到了一条错误信息,那你需要确保你的显卡驱动是最新的,包含 Vulkan 运行时,并且你的显卡支持 Vulkan。主流品牌的驱动下载链接详见介绍章节。

MacOS

SDK 可在 LunarG 网站 下载。创建账户不是必须的,但它会给你阅读一些或许对你有用的额外文档的权限。

MacOS 版本的 SDK 在内部使用了 MoltenVK。Vulkan 在 MacOS 上没有原生支持,所以 MoltenVK 会作为中间层把 Vulkan API 的调用翻译至苹果的 Metal 图形框架。这样你就可以享受到苹果的 Metal 框架在调试与性能上的优点。

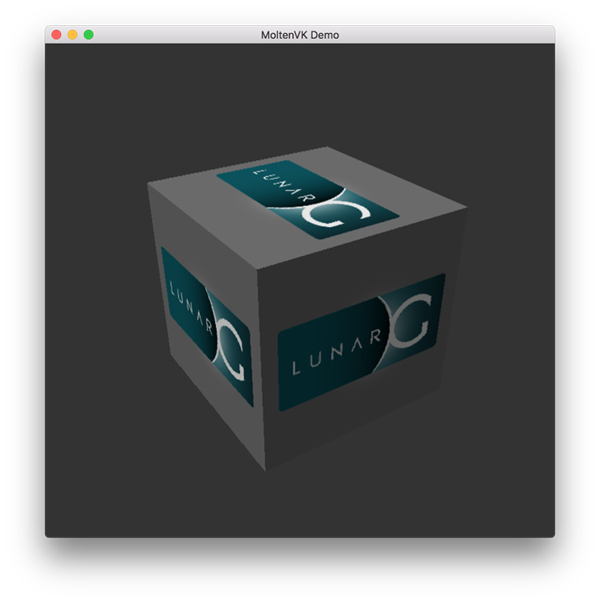

下载完成之后,将其解压到你自己选择的文件夹。在解压后的文件夹内,你可以在 Applications 文件夹中找到一些使用 SDK 运行的示例应用的可执行文件。运行 vkcube 示例应用,你会看到这个画面:

环境配置

当在 Vulkan SDK 目录以外的地方运行 Vulkan 应用程序时,你可能会需要运行由 Vulkan SDK 提供的 setup-env.sh 脚本,以避免找不到 Vulkan 库(例如 libvulkan.dylib)导致的问题。如果你把 Vulkan SDK 安装到了默认位置,脚本应该可以在如下目录中找到:~/VulkanSDK/1.3.280.1/setup-env.sh(用你实际安装的版本号替换 1.3.280.1 以匹配你的 Vulkan 安装)。

你也可以把这个脚本添加到你 Shell 的启动脚本中,这样它就能自动运行了。例如你可以在 ~/.zshrc 文件中添加这样一行:

source ~/VulkanSDK/1.3.280.1/setup-env.sh

FAQ

原文链接:https://kylemayes.github.io/vulkanalia/faq.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本页面列举了在开发 Vulkan 应用时可能遇到的常见问题及其解决方案。

-

(MacOS) 我安装了 Vulkan SDK,但我运行 Vulkan 应用程序的时候遇到了找不到

libvulkan.dylib的错误 —— 参见MacOS Vulkan SDK 安装说明中的环境配置章节。 -

我在核心校验层中遇到了访问冲突(access violation)错误 – 确保未运行 MSI Afterburner / RivaTuner Statistics Server,因为它们和 Vulkan 之间存在一些兼容性问题。

-

我看不到任何来自校验层的消息/校验层不可用 – 首先确保校验层有机会打印错误信息,请在程序退出后保持终端窗口打开。在 Visual Studio 中,你可以通过使用 Ctrl-F5 而不是 F5 来运行程序;在 Linux 中,你可以从终端窗口执行程序。如果仍然没有消息,并且你确信校验层已启用,那么你应该按照此页面上的“Verify the Installation”说明来确保 Vulkan SDK 已正确安装。同时确保你的 SDK 版本至少为 1.1.106.0,以支持

VK_LAYER_KHRONOS_validation校验层。 -

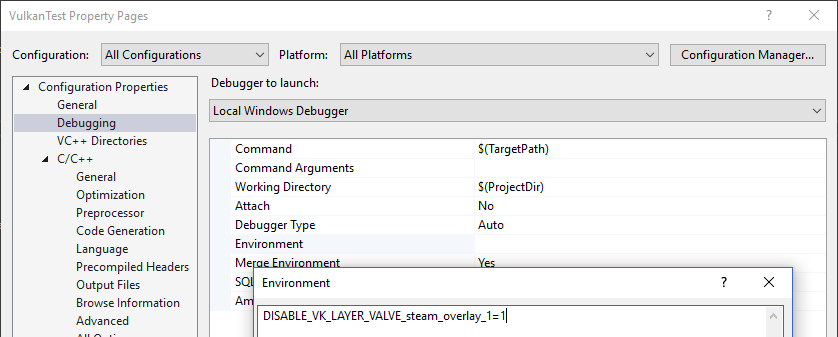

vkCreateSwapchainKHR在SteamOverlayVulkanLayer64.dll中引发错误 – 这似乎是测试版 Steam 客户端中的一个兼容性问题。以下有几个也许可行的解决方法:- 退出 Steam 测试计划

- 将环境变量

DISABLE_VK_LAYER_VALVE_steam_overlay_1设置为1。 - 删除注册表中

HKEY_LOCAL_MACHINE\SOFTWARE\Khronos\Vulkan\ImplicitLayers下的 Steam overlay Vulkan layer 项目。

示例:

基础代码

原文链接:https://kylemayes.github.io/vulkanalia/setup/base_code.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs

在开发环境一章中,我们创建了一个 Cargo 项目添加了必要的依赖项目。在本章中,我们会用下面的代码替换 src/main.rs 中的内容:

#![allow( dead_code, unused_variables, clippy::too_many_arguments, clippy::unnecessary_wraps )] use anyhow::Result; use winit::dpi::LogicalSize; use winit::event::{Event, WindowEvent}; use winit::event_loop::, EventLoop; use winit::window::{Window, WindowBuilder}; fn main() -> Result<()> { pretty_env_logger::init(); // 创建窗口 let event_loop = EventLoop::new()?; let window = WindowBuilder::new() .with_title("Vulkan Tutorial (Rust)") .with_inner_size(LogicalSize::new(1024, 768)) .build(&event_loop)?; // 初始化应用程序 let mut app = unsafe { App::create(&window)? }; let mut app = unsafe { App::create(&window)? }; event_loop.run(move |event, elwt| { match event { // Request a redraw when all events were processed. Event::AboutToWait => window.request_redraw(), Event::WindowEvent { event, .. } => match event { // Render a frame if our Vulkan app is not being destroyed. WindowEvent::RedrawRequested if !elwt.exiting() => unsafe { app.render(&window) }.unwrap(), // Destroy our Vulkan app. WindowEvent::CloseRequested => { elwt.exit(); unsafe { app.destroy(); } } _ => {} } _ => {} } })?; Ok(()) } /// 我们的 Vulkan 应用程序 #[derive(Clone, Debug)] struct App {} impl App { /// 创建 Vulkan App unsafe fn create(window: &Window) -> Result<Self> { Ok(Self {}) } /// 渲染帧 unsafe fn render(&mut self, window: &Window) -> Result<()> { Ok(()) } /// 销毁 Vulkan App unsafe fn destroy(&mut self) {} } /// 我们的 Vulkan 应用程序所使用的 Vulkan 句柄和相关属性 #[derive(Clone, Debug, Default)] struct AppData {}

首先我们导入 anyhow::Result,这样我们就可以为程序中所有可失败的函数使用 anyhow 提供的 Result 类型。接下来我们导入所有 winit 类型,这些类型将被用于创建窗口并且启动窗口的事件循环。

接着是我们的 main 函数(它返回一个 anyhow::Result)。这个函数首先初始化 pretty_env_logger,它将会把日志打印到控制台(稍后会展示)。

接着,我们创建一个事件循环(event loop),并用 winit 和 LogicalSize 来创建一个窗口作为渲染的目标。LogicalSize 会根据你的显示器的 DPI 来缩放窗口。如果你想了解更多关于 UI 缩放的内容,可以阅读 winit 文档。

接着,我们创建一个我们的 Vulkan 应用(App)的实例,并进入渲染循环。这个循环会持续将我们的场景渲染到窗口,直到你请求关闭窗口 —— 此时应用程序会被销毁并且程序会退出。destroying 标志是必要的,因为在应用程序被销毁时,我们不希望继续渲染场景,否则程序很可能会在尝试访问已被销毁的 Vulkan 资源时崩溃。

最后是 App 和 AppData,App 会被用来实现 Vulkan 程序所需的设置、渲染和析构逻辑。在接下来的章节中,我们都会围绕这个 Vulkan 程序工作。我们会创建非常多的 Vulkan 资源,AppData 会被用作容纳这些资源的容器,这样我们就可以轻松地将这些资源传递给函数。

这样做非常方便,因为我们接下来的很多章节都是加入一个接受 &mut AppData 的函数,创建并初始化 Vulkan 资源。这些函数会在 App::create 构造器中被调用来初始化我们的 Vulkan 应用。并且,在程序结束前,这些 Vulkan 资源会被 App::destory 方法销毁。

一个关于安全性的注解

所有的 Vulkan 函数,无论是原始函数还是它们的封装,在 vulkanalia 中都是被标记为 unsafe 的。这是因为许多 Vulkan 函数对如何调用它们作了限制,而 Rust 无法确保这些限制(除非引入一个更高阶的接口来隐藏 Vulkan API,例如 vulkano)。

本教程通过把所有调用 Vulkan 函数的函数和方法标记为 unsafe 来解决这一问题。这可以最大程度上减少语法噪音,但一个真实的程序中你可能希望自己封装一个安全的接口,并自行确保调用 Vulkan 函数时的正确性。

资源管理

正如在 C 中使用 malloc 分配的每一块内存都需要对应一个 free 调用一样,对于我们创建的每一个 Vulkan 对象,我们都要在不再需要它时显式地将其销毁。在 Rust 中,使用资源分配即初始化(Resource Acuisition Is Initialization, RAII)配合像 Rc 和 Arc 这样的智能指针来自动管理资源是可行的。然而,https://vulkan-tutorial.com 的作者选择在教程中显式地创建和销毁 Vulkan 对象,并且我也打算采用同样的方式。毕竟,Vulkan 的特点就是每一个操作都要显式地进行以避免错误,所以显式地管理对象的生命周期也是很好的学习 API 工作方式的途径。

在完成本教程之后,你就可以编写 Rust 结构体来包装 Vulkan 对象,并在其 Drop 实现中释放 Vulkan 对象,从而实现自动资源管理。对于大规模的 Vulkan 程序而言,RAII 是推荐的模式,但是为了学习,了解背后发生了什么也是很有好处的。

Vulkan 对象要么是由 create_xxx 之类的函数直接创建出来的,要么是通过另一个对象和 allocate_xxx 之类的函数分配出来的。在确保一个对象不会再使用之后,你需要用对应的 destroy_xxx 或者 free_xxx 来销毁它。这些函数的参数通常因对象的类型不同而有所不同,但是它们都有一个共同的参数:allocator。这是一个可选参数,允许你指定一个自定义内存分配器的回调函数。在本教程中我们会忽略这个参数,总是传递 None。

Vulkan 实例

原文链接:https://kylemayes.github.io/vulkanalia/setup/instance.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs

你首先要做的事情就是通过创建一个实例来初始化 Vulkan 库。实例是你的应用程序和 Vulkan 库之间的连接,创建它涉及到向驱动程序指定一些关于你的应用程序的细节。首先,添加下面的导入:

use anyhow::{anyhow, Result};

use log::*;

use vulkanalia::loader::{LibloadingLoader, LIBRARY};

use vulkanalia::window as vk_window;

use vulkanalia::prelude::v1_0::*;这里我们引入 anyhow! 宏,这个宏可以让我们轻松地构造 anyhow 错误的实例。然后,我们引入 log::*,这样我们就可以使用 log crate 中的日志宏。接下来,我们引入 LibloadingLoader,它是 vulkanalia 提供的 libloading 集成,我们会用它来从 Vulkan 共享库中加载最初的 Vulkan 函数。你操作系统上的 Vulkan 共享库(例如 Windows 上的 vulkan-1.dll)将会被导入为 LIBRARY。

接着我们将 vulkanalia 对窗口的集成导入为 vk_window,我们将在本章中使用它来枚举渲染到窗口所需的全局 Vulkan 扩展。在将来的章节中,我们还将使用 vk_window 来将 Vulkan 实例与 winit 窗口链接起来。

最后我们从 vulkanalia 引入 Vulkan 1.0 的 prelude 模块,它将为本章和将来的章节提供我们需要的所有其他 Vulkan 相关的导入。

要创建一个实例,我们就要用我们的应用程序的一些信息来填充一个 vk::ApplicationInfo 结构体。技术上来说,这些数据是可选的,但它们可以给驱动程序提供一些有用的信息,以便优化我们的特定应用程序(例如我们的应用程序使用了某个众所周知的图形引擎,这个引擎具有某些特定的行为)。我们将在函数 create_instance 中创建 vk::ApplicationInfo 结构体,create_instance 函数接受我们的窗口和一个 Vulkan 入口点(entry point,我们将在后面创建)并返回一个 Vulkan 实例:

unsafe fn create_instance(window: &Window, entry: &Entry) -> Result<Instance> {

let application_info = vk::ApplicationInfo::builder()

.application_name(b"Vulkan Tutorial\0")

.application_version(vk::make_version(1, 0, 0))

.engine_name(b"No Engine\0")

.engine_version(vk::make_version(1, 0, 0))

.api_version(vk::make_version(1, 0, 0));

}在 Vulkan 中,许多信息都是通过结构体而非函数参数传递的,所以我们再需要填充一个结构体,来提供创建一个实例所需的信息。下一个结构体不是可选的,它会告诉 Vulkan 驱动程序我们想要使用哪些全局扩展和校验层。这里的“全局”意味着这些扩展和校验层适用于整个程序,而不是特定的设备。“全局”和“设备”的概念将在接下来的几章中逐渐变得清晰。首先我们需要使用 vulkanalia 的窗口集成 vk_window 来枚举所需的全局扩展,并将它们转换为以空字符结尾的 C 字符串(null-terminated C strings,*const c_char):

let extensions = vk_window::get_required_instance_extensions(window)

.iter()

.map(|e| e.as_ptr())

.collect::<Vec<_>>();在有了所需的全局扩展列表之后,我们就可以使用传入此函数的 Vulkan 入口点来创建 Vulkan 实例并将其返回了:

let info = vk::InstanceCreateInfo::builder()

.application_info(&application_info)

.enabled_extension_names(&extensions);

Ok(entry.create_instance(&info, None)?)如你所见,Vulkan 中的对象创建函数参数的一般模式是:

- 包含创建信息的结构体的引用

- 可选的自定义分配器回调的引用,本教程中始终为

None

现在我们有了一个可以通过入口点创建 Vulkan 实例的函数,接下来我们需要创建一个 Vulkan 入口点。这个入口点将加载用于查询实例支持和创建实例的 Vulkan 函数。但在此之前,先向我们的 App 结构体添加一些字段来存储我们将要创建的 Vulkan 入口点和实例:

struct App {

entry: Entry,

instance: Instance,

}接着,像这样更新 App::create 方法,以填充 App 中的这些字段:

unsafe fn create(window: &Window) -> Result<Self> {

let loader = LibloadingLoader::new(LIBRARY)?;

let entry = Entry::new(loader).map_err(|b| anyhow!("{}", b))?;

let instance = create_instance(window, &entry)?;

Ok(Self { entry, instance })

}这里我们首先创建了一个 Vulkan 函数加载器,用来从 Vulkan 共享库中加载最初的 Vulkan 函数,接着我们使用这个函数加载器创建 Vulkan 入口点,这个入口点将会加载我们需要的所有 Vulkan 函数。最后,我们用 Vulkan 入口点调用 create_instance 函数来创建 Vulkan 实例。

清理工作

只有当程序将要退出时,Instance 实例才应该被销毁。可以在 App::destroy 方法中使用 destroy_instance 销毁实例:

unsafe fn destroy(&mut self) {

self.instance.destroy_instance(None);

}和创建对象所用的 Vulkan 函数一样,用于销毁对象的 Vulkan 函数也接受一个可选的、指向自定义分配器回调的引用。所以和之前一样,我们传入 None 来使用默认的分配器行为。

不合规的 Vulkan 实现

不幸的是,并非每个平台都有一个完全符合 Vulkan 规范的 Vulkan API 的实现。在这样的平台上,可能会有一些标准的 Vulkan 特性是不可用的,或者 Vulkan 应用程序的实际行为与 Vulkan 规范有很大的不同。

在 Vulkan SDK 的 1.3.216 版本之后,使用不合规 Vulkan 实现的应用程序必须启用一些额外的 Vulkan 扩展。这些兼容性扩展的主要目的是强制开发人员承认他们的应用程序正在使用不合规的 Vulkan 实现,并且他们不期望一切都按 Vulkan 规范进行。

本教程会使用这些兼容性 Vulkan 扩展,这样你的程序就可以在缺少完全符合 Vulkan 实现的平台上运行了。

然而,你可能会问:“为什么我们要这么做?我们真的需要在一个入门级的 Vulkan 教程中考虑对小众平台的支持吗?”而事实证明,不那么小众的 macOS 就是那些缺少完全符合 Vulkan 实现的平台之一。

就如我们在介绍中提到的,Apple 有他们自己的底层图形 API,Metal。Vulkan SDK 为 macOS 提供的 Vulkan 实现(MoltenVK)是一个位于应用程序和 Metal 之间的中间层,它将应用程序所做的 Vulkan API 调用转换为 Metal API 调用。因为 MoltenVK 不完全符合 Vulkan 规范,所以你需要启用我们在本教程中将要讨论的兼容性 Vulkan 扩展来支持 macOS。

顺带一提,尽管 MoltenVK 不是完全合规的实现,但在 macOS 上实践本教程时,应该也是不会有任何问题的。

启用兼容性扩展

注意: 就算你用的不是 macOS,本节中添加的一些代码也会在本教程的后续部分中被引用,所以你不能跳过它们!

我们希望检查我们所用的 Vulkan 版本是否高于引入兼容性扩展要求的 Vulkan 版本。我们首先添加一个额外的导入:

use vulkanalia::Version;导入 vulkanalia::Version 之后,我们就可以定义一个常量来表示最低版本:

const PORTABILITY_MACOS_VERSION: Version = Version::new(1, 3, 216);接着,像这样修改枚举扩展并创建实例的代码:

let mut extensions = vk_window::get_required_instance_extensions(window)

.iter()

.map(|e| e.as_ptr())

.collect::<Vec<_>>();

// 从 Vulkan 1.3.216 之后,macOS 上的 Vulkan 实现需要启用额外的扩展

let flags = if

cfg!(target_os = "macos") &&

entry.version()? >= PORTABILITY_MACOS_VERSION

{

info!("Enabling extensions for macOS portability.");

extensions.push(vk::KHR_GET_PHYSICAL_DEVICE_PROPERTIES2_EXTENSION.name.as_ptr());

extensions.push(vk::KHR_PORTABILITY_ENUMERATION_EXTENSION.name.as_ptr());

vk::InstanceCreateFlags::ENUMERATE_PORTABILITY_KHR

} else {

vk::InstanceCreateFlags::empty()

};

let info = vk::InstanceCreateInfo::builder()

.application_info(&application_info)

.enabled_extension_names(&extensions)

.flags(flags);这些代码会在 Vulkan 版本高于我们定义的最小版本,而平台又缺乏完全合规的 Vulkan 实现(这里只检查了 macOS)的情况下启用 KHR_PORTABILITY_ENUMERATION_EXTENSION 兼容性扩展。

这段代码还会启用 KHR_GET_PHYSICAL_DEVICE_PROPERTIES2_EXTENSION 扩展。启用 KHR_PORTABILITY_SUBSET_EXTENSION 需要先启用这个扩展。我们在后面的教程中创建逻辑设备时会用到 KHR_PORTABILITY_SUBSET_EXTENSION 扩展。

Instance 和 vk::Instance

当我们调用 create_instance 函数时,我们得到的不是 Vulkan 函数 vkCreateInstance 返回的原始 Vulkan 实例,而是一个 vulkanalia 中的自定义类型,它将原始 Vulkan 实例和为该特定实例加载的函数结合在一起。

我们使用的 Instance 类型(从 vulkanalia 的 prelude 模块中导入)不应和 vk::Instance 混淆。vk::Instance 类型是原始的 Vulkan 实例。在后面的章节中,我们也会用到 Device 类型。和 Instance 类似的是,Device 也由原始 Vulkan 设备(vk::Device)和为该设备加载的函数组成。幸运的是,本教程中我们不需要直接使用 vk::Instance 或者 vk::Device,所以你不用担心弄混它们。

因为 Instance 中包含了 Vulkan 实例和与之关联的函数,所以 Instance 的函数封装也能够在需要原始 Vulkan 实例时提供它。

如果你查看 vkDestroyInstance 函数的文档,你会发现它接受两个参数:要销毁的实例和可选的自定义分配器回调。然而,destroy_instance 只接受可选的自定义分配器回调,因为它能够提供原始 Vulkan 实例作为第一个参数,就像上面描述的那样。

创建完实例之后,在继续进行更复杂的步骤之前,是时候拿出校验层,看看我们的调试功能了。

校验层

原文链接:https://kylemayes.github.io/vulkanalia/setup/validation_layers.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs

Vulkan API 的设计秉持了尽可能降低驱动开销的理念,带来的影响就是 API 默认只提供极少的错误检查。即便是像把枚举设置成了一个非法值这样简单的错误也不会被显式处理,而是会导致程序崩溃或是未定义行为。由于 Vulkan 要求你明确你所做的事,你很容易就会犯下许多小错误,例如在使用一个 GPU 特性时忘记在创建逻辑设备时请求这个特性。

然而,这并不意味着 Vulkan API 就没法进行错误检查。Vulkan 引入了一个优雅的系统,叫做校验层(Validation Layer)。校验层是可选的,它们能在你调用 Vulkan 函数时插入钩子,执行额外的操作。一些常见的操作包括:

- 对比规范检查参数值,以检测是否有误用

- 追踪对象的创建和销毁,找出资源泄漏

- 通过追踪发起调用的线程,检查线程安全性

- 在标准输出中打印含有所有调用及其参数的日志

- 追踪 Vulkan 调用,用于性能分析(profiling)与重放(replay)

诊断校验层中一个函数的实现看起来就像这样(C 语言):

VkResult vkCreateInstance(

const VkInstanceCreateInfo* pCreateInfo,

const VkAllocationCallbacks* pAllocator,

VkInstance* instance

) {

if (pCreateInfo == nullptr || instance == nullptr) {

log("Null pointer passed to required parameter!");

return VK_ERROR_INITIALIZATION_FAILED;

}

return real_vkCreateInstance(pCreateInfo, pAllocator, instance);

}

你可以随意堆叠校验层来引入你感兴趣的调试功能。你只需为 Debug 构建启用校验层,而在 Release 构建禁用它们,就能使这两个构建获得最大收益。

Vulkan 并不内置任何校验层,但是 LunarG Vulkan SDK 提供了一系列校验层,用以检查常见的错误。它们是完全开源的,所以你可以找到它们能检查的错误类型,并且可以参与贡献。你的应用可能会因为无意中依赖于未定义行为而在不同的驱动程序上遇到错误,而要避免这种事,最好的方式就是使用校验层。

校验层只能在安装到系统中之后使用。比如 LunarG 校验层只能在安装了 Vulkan SDK 的电脑上使用。

之前,在 Vulkan 中有两种不同类型的校验层:实例(instance)特定的校验层与设备(device)特定的校验特定层。实例特定的校验层会检查与全局 Vulkan 对象 —— 例如 Vulkan 实例 —— 相关的调用,而设备特定的校验层只会检查与某个特定的 GPU 相关的调用。设备特定的校验层现在已经被弃用了,这也就意味着实例特定的校验层会对所有的 Vulkan 调用生效。规范文档依旧建议你出于兼容性考虑启用设备特定的校验层,而这在某些实现中是必须的。我们将简单地在逻辑设备级别指定与实例相同的校验层,稍后我们会看到。

在开始之前,我们需要为本章节添加一些新的引入:

use std::collections::HashSet;

use std::ffi::CStr;

use std::os::raw::c_void;

use vulkanalia::vk::ExtDebugUtilsExtension;HashSet 会被用来存储与查询支持的校验层,vk::ExtDebugUtilsExtension 提供管理调试功能的函数封装。其它引入会被用于记录校验层传来的消息。

使用校验层

在这个章节中,我们将会学习如何启用 Vulkan SDK 提供的标准校验层。和扩展一样,启用校验层需要指定它们的名称。在 SDK 中,所有有用的标准校验都被打包于 VK_LAYER_KHRONOS_validation 校验层中。

我们先给我们程序增加两个配置变量,一个用来指定需要启用的校验层,一个用来指定是否启用校验层。我决定根据程序是否使用 Debug 模式编译来选择是否启用校验层。

const VALIDATION_ENABLED: bool =

cfg!(debug_assertions);

const VALIDATION_LAYER: vk::ExtensionName =

vk::ExtensionName::from_bytes(b"VK_LAYER_KHRONOS_validation");我们给 create_instance 函数加一些新的代码,用来收集所有支持的实例特定校验层并将其存储在一个 HashSet 中,然后使用这个 HashSet 检查我们需要的校验层是否可用,并创建一个包含校验层名称的列表。这些代码应该放在构建 vk::ApplicationInfo 结构体的正下方:

let available_layers = entry

.enumerate_instance_layer_properties()?

.iter()

.map(|l| l.layer_name)

.collect::<HashSet<_>>();

if VALIDATION_ENABLED && !available_layers.contains(&VALIDATION_LAYER) {

return Err(anyhow!("Validation layer requested but not supported."));

}

let layers = if VALIDATION_ENABLED {

vec![VALIDATION_LAYER.as_ptr()]

} else {

Vec::new()

};然后,你需要调用 enabled_layer_names,在 vk::InstanceCreateInfo 中指定需要启用的校验层:

let info = vk::InstanceCreateInfo::builder()

.application_info(&application_info)

.enabled_layer_names(&layers)

.enabled_extension_names(&extensions)

.flags(flags);现在,在 Debug 模式下执行程序,并且确保没有跳出 Validation layer requested but not supported. 这条错误信息。如果看到报错信息,那你需要看一下 FAQ。如果一切顺利,那么 create_instance 应该永远都不会返回错误代码 vk::ErrorCode::LAYER_NOT_PRESENT,不过你还是应该运行程序以确保万无一失。

消息回调

默认情况下,校验层会将调试消息打印至标准输出,但我们也可以提供显式回调自己处理这些消息。这样我们可以自主决定处理哪些类型的消息,因为并非所有消息都是(致命)错误消息。如果你不想现在做这些事,你可以跳到本章的最后一节。

要在程序中配置一个处理消息和消息细节的回调,我们需要使用 VK_EXT_debug_utils 扩展配置一个带回调的调试信使(debug messenger)。

我们会往 create_instance 函数中函数添加更多代码。这次我们需要将 extensions 列表改为可变的,然后在校验层启用时将调试实用工具扩展(debug utilities extension)加入这个列表:

let mut extensions = vk_window::get_required_instance_extensions(window)

.iter()

.map(|e| e.as_ptr())

.collect::<Vec<_>>();

if VALIDATION_ENABLED {

extensions.push(vk::EXT_DEBUG_UTILS_EXTENSION.name.as_ptr());

}vulkanalia 为每个 Vulkan 扩展提供了一系列元数据。在这个例子中,我们只需要加载扩展的名称,所以我们将 vk::EXT_DEBUG_UTILS_EXTENSION 结构体常量的 name 字段的值添加到我们的扩展名称列表中。

运行程序,确保你没有收到 vk::ErrorCode::EXTENSION_NOT_PRESENT 错误代码。事实上,我们并不需要检查这个扩展是否存在,因为只要校验层可用,这个扩展就应该可用。

现在让我们看看调试回调函数是什么样的。添加一个名为 debug_callback 的 extern "system" 函数,它的签名与 vk::PFN_vkDebugUtilsMessengerCallbackEXT 原型相匹配。extern "system" 是必须的,这样 Vulkan 才能正确调用我们的 Rust 函数。

extern "system" fn debug_callback(

severity: vk::DebugUtilsMessageSeverityFlagsEXT,

type_: vk::DebugUtilsMessageTypeFlagsEXT,

data: *const vk::DebugUtilsMessengerCallbackDataEXT,

_: *mut c_void,

) -> vk::Bool32 {

let data = unsafe { *data };

let message = unsafe { CStr::from_ptr(data.message) }.to_string_lossy();

if severity >= vk::DebugUtilsMessageSeverityFlagsEXT::ERROR {

error!("({:?}) {}", type_, message);

} else if severity >= vk::DebugUtilsMessageSeverityFlagsEXT::WARNING {

warn!("({:?}) {}", type_, message);

} else if severity >= vk::DebugUtilsMessageSeverityFlagsEXT::INFO {

debug!("({:?}) {}", type_, message);

} else {

trace!("({:?}) {}", type_, message);

}

vk::FALSE

}第一个参数表示消息的严重程度,它可以有以下取值:

vk::DebugUtilsMessageSeverityFlagsEXT::VERBOSE– 诊断信息vk::DebugUtilsMessageSeverityFlagsEXT::INFO– 提示消息,例如资源的创建vk::DebugUtilsMessageSeverityFlagsEXT::WARNING– 行为不一定是错误,但很可能意味着你的程序有 bugvk::DebugUtilsMessageSeverityFlagsEXT::ERROR– 行为无效,可能会导致崩溃

枚举值被设置为递增的,这样就可以用比较运算符来检查一条消息是否比某个严重程度更严重。我们根据这一点来决定在记录消息时使用哪个 log 宏。

type_ 参数可以有以下取值:

vk::DebugUtilsMessageTypeFlagsEXT::GENERAL– 与规范或性能无关的事件vk::DebugUtilsMessageTypeFlagsEXT::VALIDATION– 违反规范或可能是错误的事件vk::DebugUtilsMessageTypeFlagsEXT::PERFORMANCE– 这个用法可能不是 Vulkan 的最佳实践

data 参数指向一个 vk::DebugUtilsMessengerCallbackDataEXT 结构体,它包含了消息本身的细节,其中最重要的成员是:

message– 调试信息,以空字符结尾的 C 字符串(*const c_char)objects– 与消息相关的 Vulkan 对象句柄数组object_count– 数组中对象的数量

最后一个参数 —— 这里用 _ 忽略 —— 包含了一个指针,它在回调函数设置时被指定,允许你将自己的数据传递给它。

回调函数返回一个布尔值,它表示触发校验层消息的 Vulkan 调用是否应该被中止。如果回调函数返回 true,那么这个调用就会被中止,并且返回错误代码 vk::ErrorCode::VALIDATION_FAILED_EXT。这通常只用于测试校验层本身,所以你应该总是返回 vk::FALSE。

现在我们需要告诉 Vulkan 关于回调函数的事情。也许有点出乎意料,在 Vulkan 中,即使是调试回调函数也需要被显式地创建和销毁。这样的回调函数是调试信使(debug messenger)的一部分,你可以有任意多个这样的回调函数。在 AppData 结构体中添加一个字段:

struct AppData {

messenger: vk::DebugUtilsMessengerEXT,

}修改 create_instance 函数的签名与结尾,让它变得像这样:

unsafe fn create_instance(

window: &Window,

entry: &Entry,

data: &mut AppData

) -> Result<Instance> {

// ...

let instance = entry.create_instance(&info, None)?;

if VALIDATION_ENABLED {

let debug_info = vk::DebugUtilsMessengerCreateInfoEXT::builder()

.message_severity(vk::DebugUtilsMessageSeverityFlagsEXT::all())

.message_type(

vk::DebugUtilsMessageTypeFlagsEXT::GENERAL

| vk::DebugUtilsMessageTypeFlagsEXT::VALIDATION

| vk::DebugUtilsMessageTypeFlagsEXT::PERFORMANCE,

)

.user_callback(Some(debug_callback));

data.messenger = instance.create_debug_utils_messenger_ext(&debug_info, None)?;

}

Ok(instance)

}注: 对 Vulkan 标志类型调用静态方法

all(例如以上代码中的vk::DebugUtilsMessageSeverityFlagsEXT::all())会返回vulkanalia已知的所有标志。完整的标志集合中可能包括仅当特定扩展启用时才有效的标志,或是在比你所用/所面向的 Vulkan 版本更高的版本中才可用的标志。在以上代码中,我们明确列出了我们需要使用的

vk::DebugUtilsMessageTypeFlagsEXT标志,因为这个标志集包含了一个标志(vk::DebugUtilsMessageTypeFlagsEXT::DEVICE_ADDRESS_BINDING),它只有在启用了某个特定扩展 时才有效。多数情况下,使用不支持的标志不会导致任何错误或改变应用程序的行为,但如果你启用了校验层(正如我们在本章中所做的那样),那么它肯定会导致校验错误。

首先,我们从返回表达式中提取出 Vulkan 实例,这样我们就可以用它来添加我们的调试回调函数。

接着,我们构造一个 vk::DebugUtilsMessengerCreateInfoEXT 结构体,它提供了和我们的调试回调函数以及如何调用这个函数有关的信息。

message_severity 字段允许你指定你的回调函数感兴趣的所有严重程度类型。我请求所有严重程度的消息都被包含。这通常会产生大量的冗长的调试信息,但是我们可以在不感兴趣的时候通过日志级别来过滤掉这些信息。

类似地,message_type 字段允许你过滤你的回调函数感兴趣的消息类型。我在这里启用了所有类型。如果某些类型的消息对你没用,你可以禁用它们。

最后,user_callback 字段指定了回调函数。你可以选择传递一个可变引用给 user_data 字段,它会通过最后一个参数传递给回调函数。比如,你可以使用这个来传递一个指向 AppData 结构体的指针。

最后,我们调用 create_debug_utils_messenger_ext 来把我们的调试回调函数注册到 Vulkan 实例中。

因为 create_instance 函数接受一个 AppData 的引用,我们还需要更新 App 和 App::create:

注意:

AppData::default()会使用AppData结构体上的#[derive(Default)]生成的Defaulttrait 的实现。这会导致像Vec这样的容器被初始化为空列表,而像vk::DebugUtilsMessengerEXT这样的 Vulkan 句柄被初始化为空句柄。如果 Vulkan 句柄在使用之前没有被正确初始化,我们在本章中启用的校验层应该会告诉我们遗漏了什么。

struct App {

entry: Entry,

instance: Instance,

data: AppData,

}

impl App {

unsafe fn create(window: &Window) -> Result<Self> {

// ...

let mut data = AppData::default();

let instance = create_instance(window, &entry, &mut data)?;

Ok(Self { entry, instance, data })

}

}在程序退出前,我们创建的 vk::DebugUtilsMessengerEXT 对象需要被清理。我们会在 App::destroy中,在销毁实例之前做这件事:

unsafe fn destroy(&mut self) {

if VALIDATION_ENABLED {

self.instance.destroy_debug_utils_messenger_ext(self.data.messenger, None);

}

self.instance.destroy_instance(None);

}创建与销毁调试实例

尽管我们已经通过校验层添加了调试功能,但活还没完全干完。调用 create_debug_utils_messenger_ext 需要一个有效的实例,而 destroy_debug_utils_messenger_ext 必须在实例被销毁前调用。这意味着我们现在还不能调试 create_instance 和 destroy_instance 调用中的任何问题。

不过,如果你仔细阅读过扩展文档,你就会看到,还有一种方式可以为这两个函数调用创建一个单独的调试信使。只需在 vk::InstanceCreateInfo 的 next 扩展字段中传递一个指向 vk::DebugUtilsMessengerCreateInfoEXT 结构体的指针即可。在这么做之前,我们先来讨论一下在 Vulkan 中如何扩展结构体。

我们在概览章节的生成器那一节提到过,许多 Vulkan 结构体中都有一个 s_type 字段。它必须设置成正确的 vk::StructureType 枚举变体,以指示结构体的类型(例如,vk::ApplicationInfo 结构体的 s_type 字段必须设置成 vk::StructureType::APPLICATION_INFO)。

你可能好奇过这个字段的目的是什么:Vulkan 不是已经知道传递给它的结构体的类型了吗?事实上,这个字段与 next 字段的目的紧密相关:它提供了扩展 Vulkan 结构体的能力。

Vulkan 结构体中的 next 字段可以用来指定一个结构体指针链。next 可以是空指针,也可以是一个指向 Vulkan 结构体的指针,Vulkan 可以利用这一点来扩展结构体。这个链中的每个结构体都可以为传递给 Vulkan 函数的根结构体提供额外的信息。Vulkan 的这个特性允许在不破坏向后兼容性的情况下扩展 Vulkan 函数的功能。

当你将这样的结构体链传递给 Vulkan 函数时,Vulkan 函数将会遍历结构体链以收集链中所有结构体的信息。因此,Vulkan 不知道链中每个结构体的类型,这就需要 s_type 字段。

vulkanalia 提供的生成器能够轻松地以类型安全的方式构建这样的结构体链。例如,看一下 vk::InstanceCreateInfoBuilder 生成器,特别是 push_next 方法。这个方法允许将任何实现了 vk::ExtendsInstanceCreateInfo trait 的 Vulkan 结构体添加到 vk::InstanceCreateInfo 的结构体链中。

vk::DebugUtilsMessengerCreateInfoEXT 便是这种结构体之一,我们会用它来扩展 vk::InstanceCreateInfo 结构,以设置我们的调试回调函数。为了做到这一点,继续修改 create_instance 函数,这一次我们会把 info 结构体变成可变的,这样我们就可以修改它的指针链。然后将 debug_info 结构体 —— 现在也是可变的 —— 放在 info 结构体的下面,这样我们就可以将它推到 info 的指针链上:

let mut info = vk::InstanceCreateInfo::builder()

.application_info(&application_info)

.enabled_layer_names(&layers)

.enabled_extension_names(&extensions)

.flags(flags);

let mut debug_info = vk::DebugUtilsMessengerCreateInfoEXT::builder()

.message_severity(vk::DebugUtilsMessageSeverityFlagsEXT::all())

.message_type(

vk::DebugUtilsMessageTypeFlagsEXT::GENERAL

| vk::DebugUtilsMessageTypeFlagsEXT::VALIDATION

| vk::DebugUtilsMessageTypeFlagsEXT::PERFORMANCE,

)

.user_callback(Some(debug_callback));

if VALIDATION_ENABLED {

info = info.push_next(&mut debug_info);

}**注:**在这里选择同样的调试信息,包括相同的严重程度、类型和回调函数,既调用

create_debug_utils_messenger_ext又添加到vk::InstanceCreateInfo实例的扩展中,可能看起来有些多余。然而,这两种用法有不同的目的。这里的用法(将调试信息添加到vk::InstanceCreateInfo)设置了在创建和销毁实例期间的调试。调用create_debug_utils_messenger_ext为其他一切设置了持久性调试。请参阅 Vulkan 规范中相关章节中以 "To capture events that occur while creating or destroying an instance" 开头的段落。

debug_info 需要在条件语句之外定义,因为它需要一直存活到我们调用完 create_instance 之后。幸运的是,我们可以依赖 Rust 编译器来保护我们:因为 vulkanalia 生成器定义的生命周期,我们无法将一个活得不够长的结构体推到指针链上。

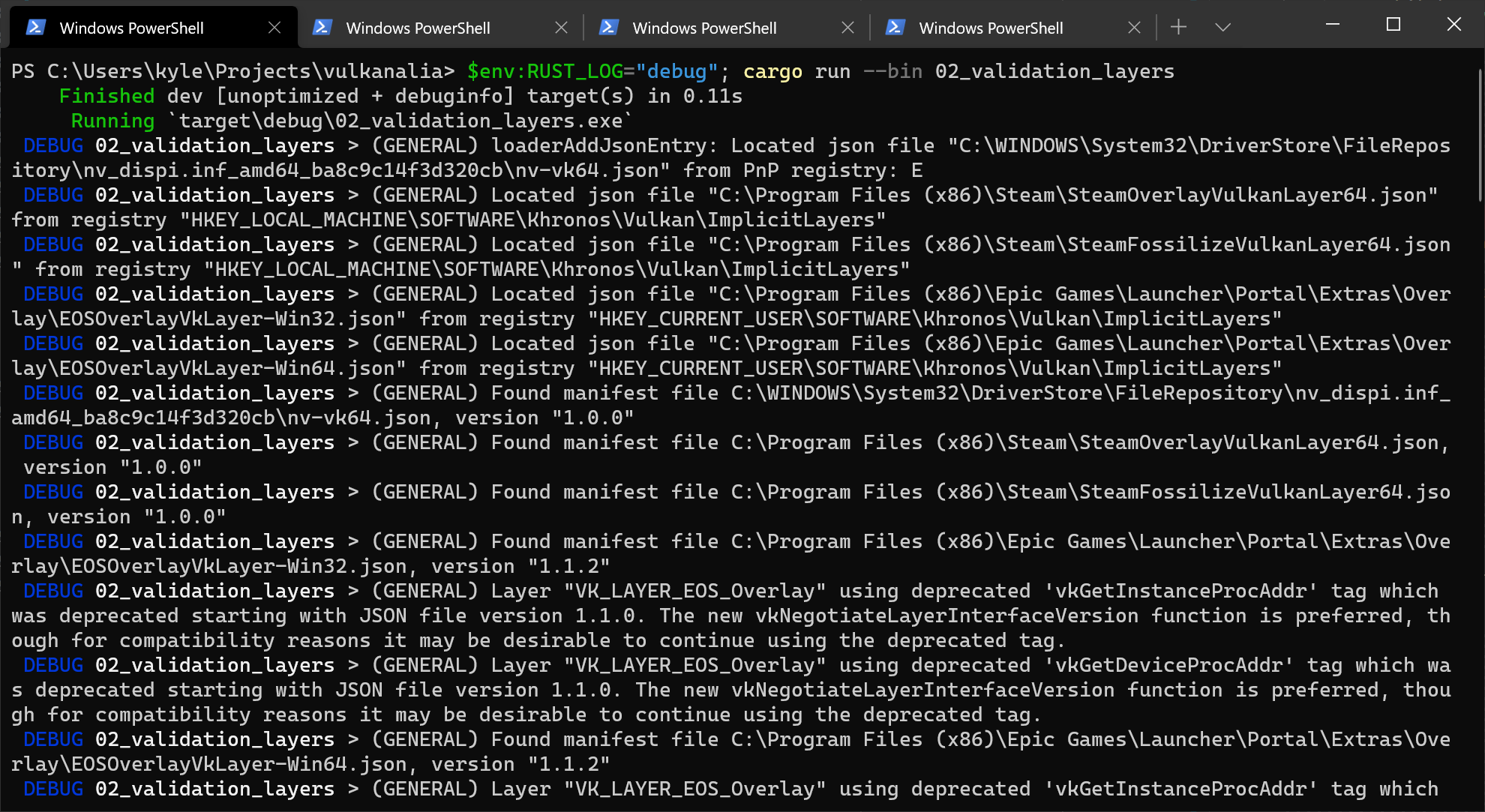

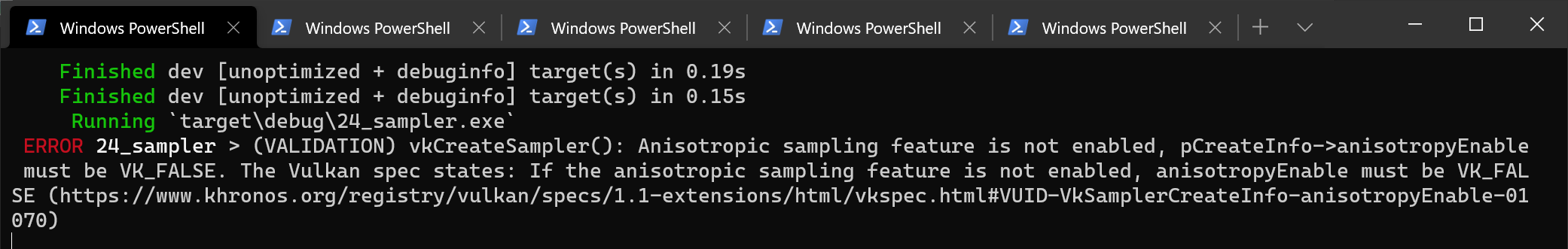

现在我们可以运行程序,观察调试回调函数打印的日志了。不过我们要先设置 RUST_LOG 环境变量,这样 pretty_env_logger 就会启用我们感兴趣的日志级别。我们先把日志级别设置为 debug,以确定这些东西工作正常。下面是在 Windows(PowerShell)上的一个例子:

如果一切正常,那你应该不会看到任何警告或者错误信息。接下来,你可能想要使用 RUST_LOG=info 来减少日志的冗长程度,除非你是在调试错误。

配置

除了 vk::DebugUtilsMessengerCreateInfoEXT 结构中的标志之外,还有更多针对校验层行为的配置项目。浏览 Vulkan SDK 所在的位置,进入 Config 目录。你会在这里找到一个 vk_layer_settings.txt 文件,它解释了如何配置校验层的行为。

要为你自己的应用程序配置校验层,你需要将文件复制到项目可执行文件的工作目录,并按照说明设置所需的行为。不过,在本教程的其余部分,我将假设你使用默认设置。

在本教程中,我会故意制造一些错误,以展示校验层是如何帮助你捕获这些错误的,并告诉你与 Vulkan 共事时清楚自己在做什么是多么重要。现在是时候看看系统中的 Vulkan 设备了。

物理设备与队列族

原文链接:https://kylemayes.github.io/vulkanalia/setup/physical_devices_and_queue_families.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs

在通过 Instance 初始化 Vulkan 库之后,我们需要在系统中选择一个支持我们所需功能的图形处理器。事实上,我们可以选择任意多个图形处理器,并同时使用它们,不过在本教程中我们只会选择第一个满足我们需求的图形处理器。

我们会添加一个 pick_physical_device 函数,用来枚举并选择图形处理器,然后将图形处理器及其相关信息存储在 AppData 中。这个函数及其调用的函数会使用一个自定义的错误类型(SuitabilityError)来表示物理设备不满足应用程序的需求。这个错误类型会使用 thiserror crate 来自动实现错误类型需要的所有的样板代码。

use thiserror::Error;

impl App {

unsafe fn create(window: &Window) -> Result<Self> {

// ...

pick_physical_device(&instance, &mut data)?;

Ok(Self { entry, instance, data })

}

}

#[derive(Debug, Error)]

#[error("Missing {0}.")]

pub struct SuitabilityError(pub &'static str);

unsafe fn pick_physical_device(instance: &Instance, data: &mut AppData) -> Result<()> {

Ok(())

}被选中的物理设备会被存储在我们刚添加到 AppData 结构体的 vk::PhysicalDevice 句柄中。当 Instance 被销毁时,这个对象也会被隐式销毁,所以我们不需要在 App::destroy 方法中做任何额外的工作。

struct AppData {

// ...

physical_device: vk::PhysicalDevice,

}设备的适用性

我们需要一种方法来确定一个物理设备是否符合我们的需求。我们会创建一个用来检测设备适用性的函数,如果我们传给这个函数的物理设备不能完全支持我们需要的功能,那么这个函数会返回一个 SuitabilityError 错误:

unsafe fn check_physical_device(

instance: &Instance,

data: &AppData,

physical_device: vk::PhysicalDevice,

) -> Result<()> {

Ok(())

}要评估一个物理设备是否满足我们的需求,我们需要从设备中查询一些详细信息。设备的名称、类型和支持的 Vulkan 版本等基本信息可以使用 get_physical_device_properties 查询:

let properties = instance

.get_physical_device_properties(physical_device);设备对可选特性,例如纹理压缩、64 位浮点类型和多视口渲染(在 VR 中很有用)的支持则可以使用 get_physical_device_features 查询:

let features = instance

.get_physical_device_features(physical_device);我们会在讨论设备内存和队列族(见下一节)的时候再讨论更多可以查询的设备细节。

举个例子,假设我们的应用程序只能在支持几何着色器(geometry shader)的独立显卡上运行。那么 check_physical_device 函数可能如下所示:

unsafe fn check_physical_device(

instance: &Instance,

data: &AppData,

physical_device: vk::PhysicalDevice,

) -> Result<()> {

let properties = instance.get_physical_device_properties(physical_device);

if properties.device_type != vk::PhysicalDeviceType::DISCRETE_GPU {

return Err(anyhow!(SuitabilityError("Only discrete GPUs are supported.")));

}

let features = instance.get_physical_device_features(physical_device);

if features.geometry_shader != vk::TRUE {

return Err(anyhow!(SuitabilityError("Missing geometry shader support.")));

}

Ok(())

}相比于直接选择第一个合适的设备,你也可以给每个设备评分,然后选择得分最高的那个。这样你就可以通过给独立显卡一个更高的分数来优先选择独立显卡,但是如果只有集成显卡可用,就回退到集成显卡。你也可以直接显示设备的名称,然后让用户自行选择。

接下来,我们会讨论第一个我们真正需要的功能。

队列族

之前已经介绍过,在 Vulkan 中进行任何操作(从绘制到纹理上传)基本都要将指令提交到队列。不同的队列族能够产生不同种类的队列,而每个队列族都只支持一部分指令。例如,一个队列族可能只允许处理计算指令,或者只允许处理内存传输相关的指令。

我们需要查询设备支持的队列族,并且找到一个支持我们所需指令的队列族。为此,我们添加一个新的结构体 QueueFamilyIndices 来存储我们需要的队列族的索引。

现在,我们只要找到一个支持图形指令的队列族就好了,那么 QueueFamilyIndices 结构体和它的 impl 块看起来就像这样:

#[derive(Copy, Clone, Debug)]

struct QueueFamilyIndices {

graphics: u32,

}

impl QueueFamilyIndices {

unsafe fn get(

instance: &Instance,

data: &AppData,

physical_device: vk::PhysicalDevice,

) -> Result<Self> {

let properties = instance

.get_physical_device_queue_family_properties(physical_device);

let graphics = properties

.iter()

.position(|p| p.queue_flags.contains(vk::QueueFlags::GRAPHICS))

.map(|i| i as u32);

if let Some(graphics) = graphics {

Ok(Self { graphics })

} else {

Err(anyhow!(SuitabilityError("Missing required queue families.")))

}

}

}get_physical_device_queue_familiy_properties 返回的队列属性包含了许多关于物理设备支持的队列族的细节,包括队列族支持的操作类型,以及基于这个队列族能创建多少队列。这里我们要找到第一个支持图形操作的队列族,这个队列族的标志是 vk::QueueFlags::GRAPHICS。

有了这个酷毙了的队列族查询方法,我们就可以在 check_physical_device 函数中使用它,来检查物理设备是否能够处理我们想要使用的指令:

unsafe fn check_physical_device(

instance: &Instance,

data: &AppData,

physical_device: vk::PhysicalDevice,

) -> Result<()> {

QueueFamilyIndices::get(instance, data, physical_device)?;

Ok(())

}最后,我们遍历所有物理设备,并选中第一个通过 check_physical_device 函数检测、符合我们要求的设备。我们更新 pick_physical_device 函数:

unsafe fn pick_physical_device(instance: &Instance, data: &mut AppData) -> Result<()> {

for physical_device in instance.enumerate_physical_devices()? {

let properties = instance.get_physical_device_properties(physical_device);

if let Err(error) = check_physical_device(instance, data, physical_device) {

warn!("Skipping physical device (`{}`): {}", properties.device_name, error);

} else {

info!("Selected physical device (`{}`).", properties.device_name);

data.physical_device = physical_device;

return Ok(());

}

}

Err(anyhow!("Failed to find suitable physical device."))

}好极了,这就是我们找到正确的物理设备所需要的一切!下一步是创建一个逻辑设备来与之交互。

逻辑设备与队列

原文链接:https://kylemayes.github.io/vulkanalia/setup/logical_device_and_queues.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs

选择了要使用的物理设备之后,我们需要创建一个与之交互的逻辑设备。创建逻辑设备的过程与创建实例的过程相似,即描述我们希望使用的功能。既然我们已经查询了可用的队列族,我们还需要指定要创建哪些队列。如果你有不同的需求,甚至可以从同一个物理设备创建多个逻辑设备。

首先,在 App 中添加一个新的字段来存储逻辑设备:

struct App {

// ...

device: Device,

}接下来,在 App::create 中调用 create_logical_device 函数,并将得到的逻辑设备添加到 App 的构造器中:

impl App {

unsafe fn create(window: &Window) -> Result<Self> {

// ...

let device = create_logical_device(&entry, &instance, &mut data)?;

Ok(Self { entry, instance, data, device })

}

}

unsafe fn create_logical_device(

entry: &Entry,

instance: &Instance,

data: &mut AppData,

) -> Result<Device> {

}指定要创建的队列

创建逻辑设备需要再创建一堆结构体来指定一堆细节,首先是 vk::DeviceQueueCreateInfo。这个结构体描述了我们单个队列族需要的队列数量。现在,我们只对具备图形功能的队列感兴趣。

let indices = QueueFamilyIndices::get(instance, data, data.physical_device)?;

let queue_priorities = &[1.0];

let queue_info = vk::DeviceQueueCreateInfo::builder()

.queue_family_index(indices.graphics)

.queue_priorities(queue_priorities);当前可用的驱动程序只允许你为每个队列族创建少量队列,实际上你也确实不需要多个队列。因为你可以在多个线程上创建指令缓冲,然后在主线程上一次性提交它们,这样只需要一次低开销的调用。

Vulkan 允许你为队列分配优先级,使用介于 0.0 和 1.0 之间的浮点数来影响指令缓冲执行的调度。即使只创建一个队列,也需要指定优先级。

指定要启用的层

接下来要提供的信息与 vk::InstanceCreateInfo 结构体相似。同样地,我们需要指定要启用的任何校验层或扩展,但这次指定的扩展是设备特定的,而不是全局的。

一个设备特定扩展的例子是 VK_KHR_swapchain,它允许你将该设备渲染的图像呈现到窗口中。一些 Vulkan 设备,例如仅支持计算操作的设备,可能不具备此功能。我们将在交换链章节中再次提到这个扩展。

Vulkan 以前的实现区分了实例和设备特定的校验层,但现在不再是这样了。这意味着在最新的实现中,我们传递给 enabled_layer_names 的层名将被忽略。不过,为了与旧版本兼容,还是应该设置这些名称。

我们还不会启用任何设备特定的扩展。因此,如果启用了校验,我们将构建一个包含校验层的层名列表。

let layers = if VALIDATION_ENABLED {

vec![VALIDATION_LAYER.as_ptr()]

} else {

vec![]

};指定要启用的扩展

正如 实例 一章中所讨论的,对于使用不完全符合 Vulkan 规范的 Vulkan 实现的应用程序,必须启用某些 Vulkan 扩展。在本章中,我们启用了与这些不符合规范的实现兼容所需的实例扩展。在这里,我们将启用出于同样目的所需的设备扩展。

let mut extensions = vec![];

// Required by Vulkan SDK on macOS since 1.3.216.

if cfg!(target_os = "macos") && entry.version()? >= PORTABILITY_MACOS_VERSION {

extensions.push(vk::KHR_PORTABILITY_SUBSET_EXTENSION.name.as_ptr());

}指定使用的设备功能

下一个需要指定的信息是我们将要使用的设备特性。这些特性是我们在上一章中通过 get_physical_device_features 查询到的,比如几何着色器。现在我们不需要任何特殊的东西,所以我们可以简单地定义它,并将所有东西都保留为默认值(false)。一旦我们要开始使用 Vulkan 做更有趣的事情,我们会再回到这个结构。

let features = vk::PhysicalDeviceFeatures::builder();创建逻辑设备

有了前面两个结构体、启用的校验层(如果启用)以及设备扩展,我们可以填充最主要的 vk::DeviceCreateInfo 结构体。

let queue_infos = &[queue_info];

let info = vk::DeviceCreateInfo::builder()

.queue_create_infos(queue_infos)

.enabled_layer_names(&layers)

.enabled_extension_names(&extensions)

.enabled_features(&features);就是这样,我们现在可以调用名为 create_device 的方法来实例化逻辑设备了。

let device = instance.create_device(data.physical_device, &info, None)?;参数是要与逻辑设备交互的物理设备、我们刚刚指定的队列和使用信息,以及可选的分配回调。与实例创建函数类似,如果启用不存在的扩展或指定了不支持的功能,则此调用可能会返回错误。

设备应在 App::destroy 中被销毁:

unsafe fn destroy(&mut self) {

self.device.destroy_device(None);

// ...

}逻辑设备不直接与实例交互,因此不作为参数。

检索队列句柄

队列会随着逻辑设备的创建而自动创建,但我们还没有取得与它们交互所用的句柄。首先,在 AppData 中添加一个新的字段来存储图形队列的句柄:

struct AppData {

// ...

graphics_queue: vk::Queue,

}设备队列会在设备销毁时自动清理,所以我们不需要在 App::destroy 中做任何处理。

我们可以使用 get_device_queue 函数来检索每个队列族的队列句柄。参数是逻辑设备、队列族和队列序号。因为我们只从该族中创建一个队列,所以我们只需使用序号 0。

data.graphics_queue = device.get_device_queue(indices.graphics, 0);最后,在 create_logical_device 中返回创建的逻辑设备:

Ok(device)有了逻辑设备和队列句柄,我们现在就可以真正开始使用显卡来执行任务了!在接下来的几章中,我们将设置资源以将结果呈现给窗口系统。

窗口表面

原文链接:https://kylemayes.github.io/vulkanalia/presentation/window_surface.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs

Vulkan 是一个平台无关的 API,因此它不能直接与窗口系统进行交互。要在屏幕上呈现结果,我们需要使用一系列 WSI(Window System Interface,窗口系统接口)扩展来建立 Vulkan 与窗口系统之间的连接。在本章中,我们将讨论第一个扩展,即 VK_KHR_surface。它暴露了一个 vk::SurfaceKHR 类型,表示一种用于呈现图像的抽象表面。我们程序中的窗口表面将由我们用 winit 打开的窗口来支持。

VK_KHR_surface 扩展是一个实例级扩展,我们实际上已经启用了它,因为它被包含在 vk_window::get_required_instance_extensions 返回的列表中。该列表还包含了我们将在接下来的几章中使用的其他 WSI 扩展。

窗口表面需要在创建实例之后立即创建,因为窗口表面实际上会影响物理设备的选择。我们之所以现在才讲窗口表面的创建,是因为窗口表面是“渲染目标与呈现”这一更大主题的一部分,在“基本设置”那部分里解释窗口表面会引起混乱。此外还要注意,窗口表面是 Vulkan 里一个完全可选的组件,如果你只需要离屏渲染,Vulkan 也可以在不创建窗口的情况下进行渲染(而 OpenGL 就必须用创建一个不可见窗口这种投机取巧的方式)。

要使用 VK_KHR_surface 扩展,我们除了要导入 vk::SurfaceKHR 类型,还需要导入 vulkanalia 的扩展 trait vk::KhrSurfaceExtension:

use vulkanalia::vk::SurfaceKHR

use vulkanalia::vk::KhrSurfaceExtension;创建窗口表面

首先,在 AppData 中,在其他字段的上面添加一个 surface 字段:

struct AppData {

surface: vk::SurfaceKHR,

// ...

}虽然 vk::SurfaceKHR 对象及其用法是与平台无关的,但创建它的过程不是,创建 vk::SurfaceKHR 的具体过程依赖于窗口系统的细节。例如在 Windows 上,创建 vk::SurfaceKHR 需要 HWND 和 HMODULE 句柄。因此,扩展中有一个特定于平台的附加部分,例如在 Windows 上,它是 VK_KHR_win32_surface。平台特定的附加部分也会被自动包含在 vk_window::get_required_instance_extensions 的列表中。

我将演示如何在 Windows 上使用这个特定于平台的扩展来创建表面,但实际上在本教程中我们不会使用它。vulkanalia 已经提供了 vk_window::create_surface,它可以处理平台之间的差异。不过在我们开始使用它之前,了解幕后的工作原理是很有好处的。

因为窗口表面是一个 Vulkan 对象,所以和其他 Vulkan 对象一样,创建它需要填充一个的 vk::Win32SurfaceCreateInfoKHR 结构体。它有两个重要的参数:hinstance 和 hwnd,分别是进程和窗口的句柄。

use winit::platform::windows::WindowExtWindows;

let info = vk::Win32SurfaceCreateInfoKHR::builder()

.hinstance(window.hinstance())

.hwnd(window.hwnd());WindowExtWindows 特性是从 winit 中导入的,它允许我们在 winit 的 Window 结构体上访问平台特定的方法。在这种情况下,它允许我们获取由 winit 创建的窗口所在进程的句柄(hinstance)和窗口的句柄(hwnd)。

之后使用 create_win32_surface_khr 创建表面,该函数包括用于表面创建的详细信息和自定义分配器的参数。从技术上讲,这是一个 WSI 扩展函数,但它的使用频率很高,所以标准的 Vulkan 加载器也会加载它,因而它不需要像其他扩展一样显式加载。不过我们还是需要为扩展 VK_KHR_win32_surface 导入 vulkanalia 的扩展 trait vk::KhrWin32SurfaceExtension。

use vk::KhrWin32SurfaceExtension;

let surface = instance.create_win32_surface_khr(&info, None).unwrap();在其他平台(如 Linux)上创建表面的过程也和上面类似。例如在 Linux 上需要使用 create_xcb_surface_khr 函数,该函数接受 XCB 连接和窗口,并在背后调用 X11 的 API。

vk_window::create_surface 函数在不同的平台上使用不同的实现执行完全相同的操作。现在,我们将其集成到程序中。在 App::create 中,在选择物理设备之前,调用该函数:

unsafe fn create(window: &Window) -> Result<Self> {

// ...

let instance = create_instance(window, &entry, &mut data)?;

data.surface = vk_window::create_surface(&instance, &window, &window)?;

pick_physical_device(&instance, &mut data)?;

// ...

}参数是 Vulkan 实例和 winit 窗口。一旦我们创建了表面,我们就需要在 App::destroy 中使用 Vulkan API 销毁它:

unsafe fn destroy(&mut self) {

// ...

self.instance.destroy_surface_khr(self.data.surface, None);

self.instance.destroy_instance(None);

}确保在销毁实例之前销毁表面。

查询呈现(presentation)支持

尽管 Vulkan 的实现可能支持窗口系统集成,但这并不意味着系统中的每个设备都支持。因此,我们需要扩展 pick_physical_device 函数的功能,以确保我们选择的设备能够向我们创建的表面呈现图像。因为呈现是与队列相关的功能,所以我们实际上是要找到一个支持向我们创建的表面进行呈现的队列族。

事实上,支持绘制指令的队列族和支持呈现的队列族可能并不重叠。因此,我们必须考虑呈现队列不同于图形队列的可能性,并修改 QueueFamilyIndices 结构体来解决此问题:

struct QueueFamilyIndices {

graphics: u32,

present: u32,

}接下来,我们将修改 QueueFamilyIndices::get 方法,以查找能向我们的窗口表面进行呈现的队列族。该方法使用 get_physical_device_surface_support_khr 函数,它以物理设备、队列族索引和表面为参数,并返回这个物理设备、队列族和表面的组合是否支持呈现:

let mut present = None;

for (index, properties) in properties.iter().enumerate() {

if instance.get_physical_device_surface_support_khr(

physical_device,

index as u32,

data.surface,

)? {

present = Some(index as u32);

break;

}

}我们还需要将 present 添加到最终的表达式中:

if let (Some(graphics), Some(present)) = (graphics, present) {

Ok(Self { graphics, present })

} else {

Err(anyhow!(SuitabilityError("Missing required queue families.")))

}请注意,这两个索引最终很可能指涉到相同的队列族,但在整个程序中,我们将把它们视为独立的队列,这样我们就可以用统一的方式来处理它们。你也可以添加逻辑来优先选择能在同一个队列中进行绘制和呈现的物理设备,以提高性能。

创建呈现队列

最后一件事是修改逻辑设备的创建过程,以创建呈现队列并取得其 vk::Queue 句柄。在 AppData 中添加一个字段来保存呈现队列的句柄:

struct AppData {

// ...

present_queue: vk::Queue,

}接下来,我们需要创建多个 vk::DeviceQueueCreateInfo 结构体来从两个队列族中创建队列。一种简单的方法是创建一个集合,用来去重并保存所有需要的队列族。我们将在 create_logical_device 函数中完成这个操作:

let indices = QueueFamilyIndices::get(instance, data, data.physical_device)?;

let mut unique_indices = HashSet::new();

unique_indices.insert(indices.graphics);

unique_indices.insert(indices.present);

let queue_priorities = &[1.0];

let queue_infos = unique_indices

.iter()

.map(|i| {

vk::DeviceQueueCreateInfo::builder()

.queue_family_index(*i)

.queue_priorities(queue_priorities)

})

.collect::<Vec<_>>();然后删除之前的 queue_infos 切片,并为 vk::DeviceCreateInfo 提供一个 queue_infos 列表的引用:

let info = vk::DeviceCreateInfo::builder()

.queue_create_infos(&queue_infos)

.enabled_layer_names(&layers)

.enabled_extension_names(&extensions)

.enabled_features(&features);最后,添加一个调用来获取队列句柄:

data.present_queue = device.get_device_queue(indices.present, 0);如果队列族相同,那么现在这两个句柄很可能具有相同的值。在下一章中,我们将讨论交换链以及它们如何使我们能够向表面呈现图像。

交换链

原文链接:https://kylemayes.github.io/vulkanalia/presentation/swapchain.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs

Vulkan 没有“默认帧缓冲”(default framebuffer)的概念,因此,Vulkan 需要一个结构来持有我们将要绘制的帧缓冲,这个架构就是交换链。在 Vulkan 中,交换链必须被显式创建。交换链本质上就是一个队列,其中充满了等待呈现到屏幕上的图像。我们的应用程序每次会从这个队列中获取一张图像,在上面绘制,然后将它返还到队列中。交换链的设置决定了这个队列如何工作,以及何时呈现队列中的图像,但通常来说,交换链的目的是使图像的呈现与屏幕刷新率同步。

检测交换链支持

出于某些原因,不是所有的显卡都能直接向屏幕呈现图像,例如有些显卡是为服务器设计的,没有图像输出接口。其次,呈现图像和窗口系统以及与窗口系统关联的表面密切相关。因此,交换链不是 Vulkan 核心的一部分。你必须先查询设备对交换链扩展 VK_KHR_swapchain 的支持,然后启用它。

像之前一样,我们首先导入 vulkanalia 的扩展 trait vk::KhrSwapchainExtension:

use vulkanalia::vk::KhrSwapchainExtension;接着,我们扩展 check_physical_device 函数,增加对 VK_KHR_swapchain 扩展支持的检查。我们之前已经看过如何列出一个物理设备支持的扩展,所以这一步应该非常直观。

首先声明一个所需设备扩展的列表,这一步和启用校验层的列表类似:

const DEVICE_EXTENSIONS: &[vk::ExtensionName] = &[vk::KHR_SWAPCHAIN_EXTENSION.name];然后创建一个新函数 check_physical_device_extensions 作为 check_physical_device 的附加检查:

unsafe fn check_physical_device(

instance: &Instance,

data: &AppData,

physical_device: vk::PhysicalDevice,

) -> Result<()> {

QueueFamilyIndices::get(instance, data, physical_device)?;

check_physical_device_extensions(instance, physical_device)?;

Ok(())

}

unsafe fn check_physical_device_extensions(

instance: &Instance,

physical_device: vk::PhysicalDevice,

) -> Result<()> {

Ok(())

}修改 check_physical_device_extensions 的函数体,枚举设备支持的所有扩展,并检查其中是否包含所有所需的扩展:

unsafe fn check_physical_device_extensions(

instance: &Instance,

physical_device: vk::PhysicalDevice,

) -> Result<()> {

let extensions = instance

.enumerate_device_extension_properties(physical_device, None)?

.iter()

.map(|e| e.extension_name)

.collect::<HashSet<_>>();

if DEVICE_EXTENSIONS.iter().all(|e| extensions.contains(e)) {

Ok(())

} else {

Err(anyhow!(SuitabilityError("Missing required device extensions.")))

}

}现在运行代码,确保你的显卡支持交换链的创建。值得注意的是,我们在前一章检查呈现队列的可用性时,已经隐式地检查了交换链扩展的支持。不过显式地检查一下也好,而且交换链扩展必须显式地启用。

启用设备扩展

使用交换链需要先启用 VK_KHR_swapchain 扩展。启用扩展只需要在 create_logical_device 函数中对设备扩展列表进行一点小小的修改。使用 DEVICE_EXTENSIONS 构造一个由空结尾的字符串组成的列表,来初始化我们的设备扩展列表:

let mut extensions = DEVICE_EXTENSIONS

.iter()

.map(|n| n.as_ptr())

.collect::<Vec<_>>();查询交换链支持的细节

只检查交换链是否可用还不够,因为它不一定和我们的窗口表面兼容。创建交换链还需要更多的设置,因此在继续推进之前,我们需要查询更多的细节。

总的来说,我们需要检查三种基本属性:

- 基本的表面能力(交换链中图像的最小/最大数量,图像的最小/最大宽度和高度)

- 表面格式(像素格式,颜色空间)

- 可用的呈现模式

与 QueueFamilyIndices 类似,我们会使用一个结构体来存储这些细节:

#[derive(Clone, Debug)]

struct SwapchainSupport {

capabilities: vk::SurfaceCapabilitiesKHR,

formats: Vec<vk::SurfaceFormatKHR>,

present_modes: Vec<vk::PresentModeKHR>,

}现在我们创建一个新的方法 SwapchainSupport::get,用来初始化这个结构体,填充我们所需的所有字段:

impl SwapchainSupport {

unsafe fn get(

instance: &Instance,

data: &AppData,

physical_device: vk::PhysicalDevice,

) -> Result<Self> {

Ok(Self {

capabilities: instance

.get_physical_device_surface_capabilities_khr(

physical_device, data.surface)?,

formats: instance

.get_physical_device_surface_formats_khr(

physical_device, data.surface)?,

present_modes: instance

.get_physical_device_surface_present_modes_khr(

physical_device, data.surface)?,

})

}

}这些字段的含义以及它们包含的数据的确切含义将在下一节中讨论。

现在,所有细节都在这个结构体里了,让我们再扩展一次 check_physical_device 函数,用这个方法来验证交换链的支持是否足够。只要交换链支持至少一种图像格式,以及至少一种给定窗口表面的呈现模式,那么这个交换链就可以满足本教程的需求。

unsafe fn check_physical_device(

instance: &Instance,

data: &AppData,

physical_device: vk::PhysicalDevice,

) -> Result<()> {

// ...

let support = SwapchainSupport::get(instance, data, physical_device)?;

if support.formats.is_empty() || support.present_modes.is_empty() {

return Err(anyhow!(SuitabilityError("Insufficient swapchain support.")));

}

Ok(())

}注意我们必须在确认交换链扩展可用之后,再检查交换链支持。

为交换链选择正确的设置

如果交换链满足我们刚刚所说的那些条件,那么这个交换链肯定是够用了。但交换链支持的设置很多,我们还需要做到最好。我们现在要写一些函数来找到最佳的交换链设置。有三种类型的设置需要确定:

- 表面格式(颜色深度)

- 呈现模式(将图像“交换”到屏幕的条件)

- 交换范围(swap extent)(交换链中图像的分辨率)

每一种设置都有一个理想值,如果这个理想值可用,我们就使用它,否则我们就创建一些逻辑来找到次佳的值。

表面格式

我们从一个下面这样的函数开始,稍后我们会把 SwapchainSupport 结构体的 formats 字段传给它作参数:

fn get_swapchain_surface_format(

formats: &[vk::SurfaceFormatKHR],

) -> vk::SurfaceFormatKHR {

}vk::SurfaceFormatKHR 有 format 和 color_space 两个成员。format 指定颜色的通道数和类型。例如,vk::Format::B8G8R8A8_SRGB 表示我们按照 B、G、R 和 alpha 通道的顺序存储颜色,每个通道使用 8 位无符号整数,每像素总共 32 位。color_space 成员使用 vk::ColorSpaceKHR::SRGB_NONLINEAR 标志表示是否支持 sRGB 颜色空间。

因为 sRGB 颜色空间可以更准确地表示颜色,所以我们会优先使用它。它也是纹理等图像的标准颜色空间。因此,我们也应该优先使用 sRGB 颜色格式,其中最常见的一个就是 vk::Format::B8G8R8A8_SRGB。

让我们遍历 formats 列表,看看是否有我们想要的组合:

fn get_swapchain_surface_format(

formats: &[vk::SurfaceFormatKHR],

) -> vk::SurfaceFormatKHR {

formats

.iter()

.cloned()

.find(|f| {

f.format == vk::Format::B8G8R8A8_SRGB

&& f.color_space == vk::ColorSpaceKHR::SRGB_NONLINEAR

})

.unwrap_or_else(|| formats[0])

}如果没有,那么我们可以评估可用格式的优劣,然后选择一个最好的。但在大多数情况下,随遇而安地使用第一个格式也行,所以我们用 unwrap_or_else 方法来简化代码。

呈现模式

呈现模式可以说是交换链中最重要的设置,因为它决定了图像什么时候被交换到屏幕上。Vulkan 中有四种可能的呈现模式:

vk::PresentModeKHR::IMMEDIATE– 应用程序提交的图像会立即传输到屏幕上,这可能会导致撕裂。vk::PresentModeKHR::FIFO– 交换链是一个队列,当显示器刷新时,显示器会从队列的前端取出一张图像,应用程序会在队列的后端插入渲染好的图像。如果队列已满,应用程序就必须等待。这种模式最类似于现代游戏中的垂直同步(vertical sync)。显示器刷新的时刻被称为“垂直空白”(vertical blank)。vk::PresentModeKHR::FIFO_RELAXED– 这种模式与FIFO的区别在于,如果程序提交图像的速度比显示器刷新的速度慢,那么图像就会立即传输,而不是等待下一个垂直空白。这可能会导致撕裂。vk::PresentModeKHR::MAILBOX– 这是FIFO模式的另一种变体。如果程序提交图像的速度比显示器刷新的速度快,当队列已满时,队列中的图像会直接被新的图像替换,而不会阻塞应用程序。这种模式可以用来尽可能快地渲染帧,同时避免撕裂,因而比标准的垂直同步有更少的延迟。这通常被称为“三重缓冲”,尽管仅靠三个缓冲本身并不能让帧率不受限制。

只有 vk::PresentModeKHR::FIFO 模式是保证可用的,因此我们需要写一个函数来查找可用的最佳模式:

fn get_swapchain_present_mode(

present_modes: &[vk::PresentModeKHR],

) -> vk::PresentModeKHR {

}我个人认为,如果能耗不是问题的话,vk::PresentModeKHR::MAILBOX 是一个非常好的折中方案。它既能避免撕裂,同时又能保持尽可能低的延迟,因为它会在垂直空白之前渲染尽可能新的图像。在移动设备上,能耗更重要,那时候你可能会想使用 vk::PresentModeKHR::FIFO。现在,让我们遍历 present_modes 列表,看看 vk::PresentModeKHR::MAILBOX 是否可用:

fn get_swapchain_present_mode(

present_modes: &[vk::PresentModeKHR],

) -> vk::PresentModeKHR {

present_modes

.iter()

.cloned()

.find(|m| *m == vk::PresentModeKHR::MAILBOX)

.unwrap_or(vk::PresentModeKHR::FIFO)

}交换范围

现在就剩交换范围一个属性了,我们再为它写一个函数:

fn get_swapchain_extent(

window: &Window,

capabilities: vk::SurfaceCapabilitiesKHR.

) -> vk::Extent2D {

}交换范围就是交换链中图像的分辨率,它几乎总是等于我们正在绘制的窗口的分辨率。可用的分辨率范围在 vk::SurfaceCapabilitiesKHR 结构体中定义。Vulkan 通过 current_extent 成员来告知适合我们窗口的交换范围。一些窗口系统会将 current_extent 的宽和高设置为一个特殊值 —— u32 类型的最大值 —— 来表示允许我们自己选择对于窗口最合适的交换范围,在这种情况下我们需要在 min_image_extent 和 max_image_extent 的范围内选择一个最合适的分辨率。

fn get_swapchain_extent(

window: &Window,

capabilities: vk::SurfaceCapabilitiesKHR,

) -> vk::Extent2D {

if capabilities.current_extent.width != u32::MAX {

capabilities.current_extent

} else {

vk::Extent2D::builder()

.width(window.inner_size().width.clamp(

capabilities.min_image_extent.width,

capabilities.max_image_extent.width,

))

.height(window.inner_size().height.clamp(

capabilities.min_image_extent.height,

capabilities.max_image_extent.height,

))

.build()

}

}我们使用 clamp 函数来限制窗口的实际大小在 Vulkan 设备支持的范围内。

创建交换链

现在我们有了所有用来帮助我们在运行时做出决策的辅助函数,我们终于有了创建工作交换链所需的所有信息。

创建一个 create_swapchain 函数,它首先调用这些辅助函数并取得其结果。然后,在 App::create 中创建逻辑设备之后调用这个函数:

impl App {

unsafe fn create(window: &Window) -> Result<Self> {

// ...

let device = create_logical_device(&instance, &mut data)?;

create_swapchain(window, &instance, &device, &mut data)?;

// ...

}

}

unsafe fn create_swapchain(

window: &Window,

instance: &Instance,

device: &Device,

data: &mut AppData,

) -> Result<()> {

let indices = QueueFamilyIndices::get(instance, data, data.physical_device)?;

let support = SwapchainSupport::get(instance, data, data.physical_device)?;

let surface_format = get_swapchain_surface_format(&support.formats);

let present_mode = get_swapchain_present_mode(&support.present_modes);

let extent = get_swapchain_extent(window, support.capabilities);

Ok(())

}除去这些属性之外,我们还需要决定交换链中图像的数量。交换链有一个工作所需的最小图像数量:

let image_count = support.capabilities.min_image_count;然而,仅仅满足这个最小值意味着我们有时候必须等待驱动程序完成内部操作,然后才能获取另一张图像来渲染。因此,建议至少请求比最小值多一张图像:

let image_count = support.capabilities.min_image_count + 1;我们也要确保我们请求的图像数量不超过最大值,其中 0 是一个特殊值,表示没有最大值:

let mut image_count = support.capabilities.min_image_count + 1;

if support.capabilities.max_image_count != 0

&& image_count > support.capabilities.max_image_count

{

image_count = support.capabilities.max_image_count;

}接下来,我们需要说明如何处理在多个队列族中使用的交换链图像。如果图形队列族与呈现队列族不同,我们的应用程序就要在图形队列上绘制交换链中的图像,然后在呈现队列上提交它们。在这种情况下,我们需要指定如何处理在多个队列族中使用的交换链图像:

vk::SharingMode::EXCLUSIVE– 一张图像同时只能被一个队列族持有,在另一个队列中使用它之前,必须显式地转移其所有权。这种方式能提供最好的性能。vk::SharingMode::CONCURRENT– 一张图像可以在多个队列族中使用,而不需要显式地转移所有权。

如果图形队列族和呈现队列族不同,我们的教程中会使用 CONCURRENT 模式,这样我们就不需要讲解所有权,毕竟这里面涉及的一些东西最好以后再详细解释。你必须使用 queue_family_indices 构建器方法提前指定哪些队列族之间可以共享交换链图像的所有权。如果图形队列族和呈现队列族相同 —— 大多数硬件都是这样的 —— 那么我们应该使用 EXCLUSIVE 模式,因为 CONCURRENT 模式要求你至少指定两个不同的队列族。

let mut queue_family_indices = vec![];

let image_sharing_mode = if indices.graphics != indices.present {

queue_family_indices.push(indices.graphics);

queue_family_indices.push(indices.present);

vk::SharingMode::CONCURRENT

} else {

vk::SharingMode::EXCLUSIVE

};和其他的 Vulkan 对象一样,创建交换链对象也要填充一个巨大的结构体。又是熟悉的开始:

let info = vk::SwapchainCreateInfoKHR::builder()

.surface(data.surface)

// continued...在指定交换链所绑定的表面之后,我们需要指定交换链图像的细节:

.min_image_count(image_count)

.image_format(surface_format.format)

.image_color_space(surface_format.color_space)

.image_extent(extent)

.image_array_layers(1)

.image_usage(vk::ImageUsageFlags::COLOR_ATTACHMENT)image_array_layers 指定每张图像的层(layer)数。除非你在开发一个立体 3D 应用程序,否则这个值总是 1。image_usage 位掩码指定我们会对交换链中的图像进行何种操作。在本教程中,我们将直接在图像上绘制,这意味着它们被用作颜色附件(color attachment)。先将图像渲染到另一个图像上、再执行后处理等操作也是可以的。在这种情况下,你可以使用 vk::ImageUsageFlags::TRANSFER_DST 这样的值,然后使用内存操作将渲染好的图像传输到交换链图像上。

.image_sharing_mode(image_sharing_mode)

.queue_family_indices(&queue_family_indices)接着我们提供图像共享模式,以及允许共享交换链图像的队列族的索引。

.pre_transform(support.capabilities.current_transform)我们可以为交换链中的图像指定一个受支持的的变换操作(capabilities 的 supported_transforms 中记录了受支持的变换),例如 90 度顺时针旋转或水平翻转。如果你不想进行任何变换,只需指定当前变换 current_transform 即可。

.composite_alpha(vk::CompositeAlphaFlagsKHR::OPAQUE)composite_alpha 方法指定是否应该使用 alpha 通道与窗口系统中的其他窗口进行混合。你几乎总是希望忽略 alpha 通道,因此使用 vk::CompositeAlphaFlagsKHR::OPAQUE。

.present_mode(present_mode)

.clipped(true)present_mode 的含义不言而喻。clipped 被设置为 true 来表示我们不关心被遮挡像素 —— 例如被窗口系统中其他窗口遮挡 —— 的颜色。除非你真的需要能够读取这些像素并获得可预测的结果,否则启用裁剪可以获得最佳性能。

.old_swapchain(vk::SwapchainKHR::null());还有最后一个方法,old_swapchain。你的交换链可能在应用程序运行时变得无效,或者不再是最优的 —— 例如当窗口大小改变的时候。在这种情况下,交换链实际上需要从头开始重建,而旧的交换链的引用必须在这个方法中指定。这是一个复杂的主题,我们将在以后的章节中讨论。现在我们假设我们只会创建一个交换链。我们可以省略这个调用,因为底层的字段默认就是一个空句柄,但为了完整起见,我们还是把它留在这里。

现在,向 AppData 中添加一个 vk::SwapchainKHR 字段来保存交换链对象:

struct AppData {

// ...

swapchain: vk::SwapchainKHR,

}创建交换链就像调用 create_swapchain_khr 方法一样简单:

data.swapchain = device.create_swapchain_khr(&info, None)?;不出所料,参数是交换链的创建信息和可选的自定义分配器。没有什么意外的。创建出的交换链需要在 App::destroy 中,在设备被销毁前清理掉:

unsafe fn destroy(&mut self) {

self.device.destroy_swapchain_khr(self.data.swapchain, None);

// ...

}现在运行程序,确保交换链创建成功。如果你在调用 vkCreateSwapchainKHR 的时候遇到了访问冲突错误,或者看到类似 Failed to find 'vkGetInstanceProcAddress' in layer SteamOverlayVulkanLayer.dll 的消息,那么请参考常见问题中关于 Steam 覆盖层的条目。

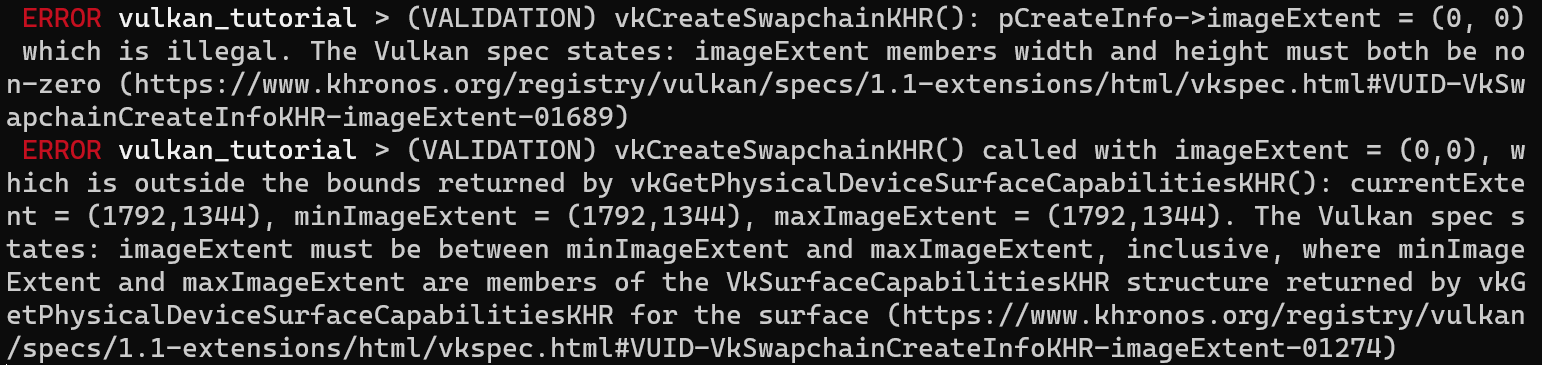

现在,不妨试试在校验层启用的情况下,在构造 vk::SwapchainCreationInfoKHR 结构体时去掉 .image_extent(extent) 这一行。你会发现,其中一个校验层立即就捕获到了错误,并打印出了一些有用的信息,指出 image_extent 的值非法:

获取交换链图像

交换链已经创建出来了,现在我们还要获取交换链中的图像 vk::Image 的句柄。我们将在后面的章节中使用这些句柄来创建渲染目标。我们将在 AppData 中添加一个 swapchain_images 字段来保存这些句柄:

struct AppData {

// ...

swapchain_images: Vec<vk::Image>,

}这些图像会随着交换链被创建出来,并且当交换链被销毁时被自动清理掉,因此我们不需要添加任何清理代码。

将下面的代码添加到 create_swapchain 函数的最后面,紧跟着 create_swapchain_khr 的调用,来获取这些句柄:

data.swapchain_images = device.get_swapchain_images_khr(data.swapchain)?;还有一件事,我们需要保存交换链中图像的格式和交换范围,因为我们将在后面的章节中用到它们。在 AppData 中添加两个字段:

struct AppData {

// ...

swapchain_format: vk::Format,

swapchain_extent: vk::Extent2D,

swapchain: vk::SwapchainKHR,

swapchain_images: Vec<vk::Image>,

}然后在 create_swapchain 中保存它们:

data.swapchain_format = surface_format.format;

data.swapchain_extent = extent;现在,我们有了一组可以绘制并呈现到屏幕上的图像。我们将在下一章中开始讨论如何将图像设置为渲染目标,然后开始使用图形管线和绘制指令来绘制图像!

图像视图 (Image views)

原文链接:https://kylemayes.github.io/vulkanalia/presentation/image_views.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs

要在渲染管线中使用任何 vk::Image —— 包括交换链中的那些,我们都需要为其创建一个图像视图对象 vk::ImageView。图像视图就像它的名字所描述的那样,它描述了如何访问图像,以及访问图像的哪一部分。例如,图像视图可以用来表示“一张图像应该被视为一张没有多级渐远层级(mipmapping levels)的二维纹理”。

在本章中,我们会实现一个 create_swapchain_image_views 函数,来为交换链中的每张图像创建一个基本的图像视图,这样我们就可以在之后的章节中将它们用作渲染目标。

首先,在 AppData 结构体中添加一个字段,用来存储图像视图:

struct AppData {

// ...

swapchain_image_views: Vec<vk::ImageView>,

}

创建一个 create_swapchain_image_views 函数,并在 App::create 中创建完交换链之后调用它:

impl App {

unsafe fn create(window: &Window) -> Result<Self> {

// ...

create_swapchain(window, &instance, &device, &mut data)?;

create_swapchain_image_views(&device, &mut data)?;

// ...

}

}

unsafe fn create_swapchain_image_views(

device: &Device,

data: &mut AppData,

) -> Result<()> {

Ok(())

}接着,我们实现 create_swapchain_image_views 函数,遍历交换链图像,并为每一张图像创建图像视图:

unsafe fn create_swapchain_image_views(

device: &Device,

data: &mut AppData,

) -> Result<()> {

data.swapchain_image_views = data

.swapchain_images

.iter()

.map(|i| {

})

.collect::<Result<Vec<_>, _>>()?;

Ok(())

}对于我们要创建的每一个图像视图,我们首先定义它的颜色分量映射。这允许你对颜色通道进行重新排序。例如,你可以将所有通道映射到红色通道,从而创建一个单色纹理。你也可以将常量值 0 和 1 映射到通道上。在我们的例子中,我们将使用默认的映射:

let components = vk::ComponentMapping::builder()

.r(vk::ComponentSwizzle::IDENTITY)

.g(vk::ComponentSwizzle::IDENTITY)

.b(vk::ComponentSwizzle::IDENTITY)

.a(vk::ComponentSwizzle::IDENTITY);接着,我们为图像视图定义子资源(subresource)范围,它描述了图像的用途以及应该访问图像的哪一部分。这里,我们的图像将被用作没有多级渐远层级,也没有多个层次的颜色目标:

let subresource_range = vk::ImageSubresourceRange::builder()

.aspect_mask(vk::ImageAspectFlags::COLOR)

.base_mip_level(0)

.level_count(1)

.base_array_layer(0)

.layer_count(1);如果你在编写一个立体 3D 应用,那么你可以创建一个包含多个层次的交换链图像视图。然后你可以访问不同的层次,并分别为左眼和右眼的视角创建各自的图像视图。

现在,我们创建一个 vk::ImageViewCreateInfo 结构体来提供创建图像视图所需的参数:

let info = vk::ImageViewCreateInfo::builder()

.image(*i)

.view_type(vk::ImageViewType::_2D)

.format(data.swapchain_format)

.components(components)

.subresource_range(subresource_range);view_type 和 format 字段指定图像数据应该如何被解释。view_type 字段用于指定图像应该被视为一维纹理、二维纹理、三维纹理还是立方体贴图。

接下来就只要调用 create_image_view 函数了:

device.create_image_view(&info, None)不同于交换链中的图像,图像视图是由我们显式创建的,所以我们需要在 App::destroy 中添加一个类似的循环来销毁它们:

unsafe fn destroy(&mut self) {

self.data.swapchain_image_views

.iter()

.for_each(|v| self.device.destroy_image_view(*v, None));

// ...

}图像视图已经足以让我们把图像作为纹理使用了,但它还不能用作渲染目标。这还需要一个额外的间接步骤 —— 帧缓冲(framebuffer)。但在这之前我们需要先建立图形管线。

介绍

原文链接:https://kylemayes.github.io/vulkanalia/pipeline/introduction.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs

在接下来的几章中,我们会搭建图形管线。它会被用来画我们的第一个三角形。图形管线是一系列将我们提交的顶点与网格纹理转换为渲染目标中的像素点的操作。下面是一个简化版的流程图:

输入装配器(input assembler)从指定缓冲中收集原始顶点数据,并且也可以使用顶点缓冲来重复使用某些元素,而不需要复制那些元素。

顶点着色器(vertex shader)对每个顶点执行,将变换应用于顶点,例如将其顶点位置从模型空间转换至屏幕空间,然后将每个顶点的数据传输至图形管线的下一阶段。

曲面细分着色器(tessellation shader)使你能够根据特定规则细分几何图形,以提升网格(mesh)的质量。这通常用于使砖墙和楼梯之类的表面从附近看上去更粗糙。

几何着色器(geometry shader)以图元(primitive,例如三角形、线、点)为单位处理几何图形。它可以剔除图元或输出更多图元。这与曲面细分着色器类似,但更灵活。然而如今的程序很少使用几何着色器,因为它在 Intel 集成显卡之外的大部分显卡上性能不佳。

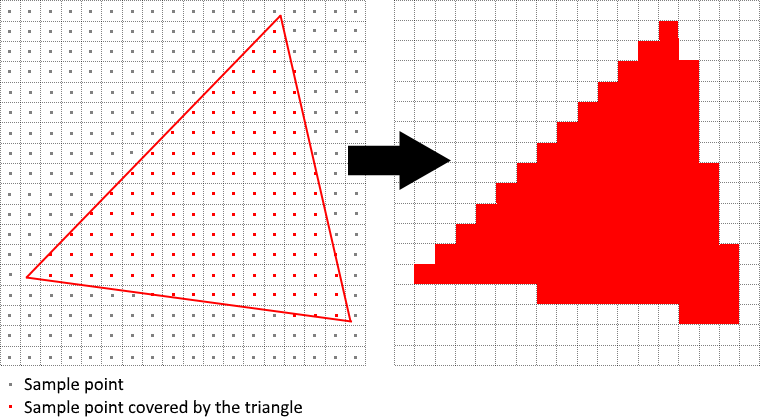

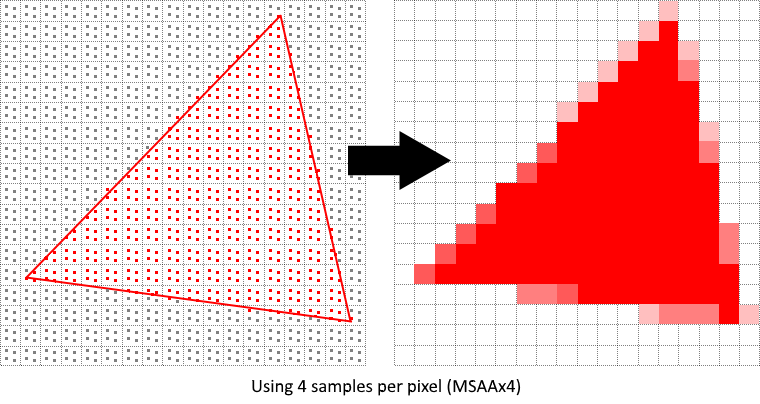

光栅化(rasterization)阶段将图元离散化(discretize)为片元(fragment)。片元用来在帧缓冲上填充像素。任何在屏幕外的片元会被丢弃,顶点着色器输出的属性会在片元之间进行插值,如上图所示。在经过深度测试(depth test)后,位于其它图元后面的片元也会被舍弃。

片元着色器(fragment shader)对每一个违背丢弃的片元执行。它会判断哪些片元要写入哪一些帧缓冲,并计算它们的颜色与深度值。它可以使用顶点着色器返回的插值后的数据,例如纹理坐标以及顶点的法线等。

混色(color blending)阶段会把在帧缓冲中同一个像素位置的不同片元进行混合。片元可以简单地覆盖彼此,也可以叠加或根据透明度混合。

标为绿色的阶段被称为固定功能(fixed-function)阶段。这些阶段所执行的工作是预定义的,但你可以通过参数对处理过程进行一定程度的配置。

标为橙色的阶段是可编程的(programmable)。你可以将自己的代码上传至显卡,并使它执行想要的操作。例如,你可以使用片元着色器来实现纹理、光照,甚至是光追。这些程序会在显卡的多个核心中同时执行来并行处理多个对象,例如顶点与片元。

如果你用过更早的 API,例如 OpenGL 和 Direct3D,你可能会对 glBlendFunc 或 OMSetBlendState 之类用于修改管线设置的函数比较熟悉。而 Vulkan 的图形管线几乎是完全不可变的,所以如果你想对渲染器进行修改,绑定其它帧缓冲,或是修改混合函数,那你必须重新创建整个管线。这么做的劣势在于你需要创建多个管线来满足你渲染所需的所有不同状态的组合。但是因为你在管线上所做的所有操作都已经事先可知,驱动就可以更好地优化你的管线。

根据需求不同,一些可编程阶段是可选的。比如,如果你只是想画简单的几何图形,那么密铺和几何着色器阶段是可以被禁用的。如果你只关心深度值,那你可以禁用片元着色器阶段。这在阴影贴图的生成上很有用。

在下一章中,我们会先创建显示三角形所必须的两个可编程阶段:顶点着色器与片元着色器。混合模式、视口、光栅化之类的固定功能的配置会在下一章中介绍。最后我们配置 Vulkan 渲染管线的最后一部分 —— 指定输入与输出的帧缓冲。

我们先创建一个 create_pipeline 函数,并且在 App::create 中调用 create_swapchain_image_views 后立刻调用新创建的 create_pipeline 函数。我们会在之后几章中修改并实现这个函数。

impl App {

unsafe fn create(window: &Window) -> Result<Self> {

// ...

create_swapchain_image_views(&device, &mut data)?;

create_pipeline(&device, &mut data)?;

// ...

}

}

unsafe fn create_pipeline(device: &Device, data: &mut AppData) -> Result<()> {

Ok(())

}着色器模块

原文链接:https://kylemayes.github.io/vulkanalia/pipeline/shader_modules.html

Commit Hash: 7becee96b0029bf721f833039c00ea2a417714dd

本章代码:main.rs | shader.vert | shader.frag

不同于以往的 API,Vulkan 中的着色器代码不是以 GLSL 或者 HLSL 这种形式指定的,而是以一种被称为 SPIR-V 的字节码格式指定的。Vulkan 和 OpenCL(都是 Knronos 的 API)都使用这种字节码格式。这种格式既可以用于图形着色器,也可以用于计算着色器,不过本书中我们会关注其中与图形管线有关的部分。

字节码格式的优势在于,GPU 厂商编写的将着色器代码转换为本地代码的编译器可以简单得多。过去的经验表明,如果使用 GLSL 这种人类可读的语法,一些 GPU 厂商对标准的解释是相当灵活的。如果你恰好使用了这些厂商的 GPU,编写了一些非平凡(non-trivial)的着色器,那么你的代码可能会因为语法错误而被其他厂商的驱动程序拒绝,或者可能更糟,由于编译器的 bug,你的着色器可能会以不同的方式运行。使用 SPIR-V 这种直接的字节码格式,这种情况有望得到避免。

不过,我们也不用手写字节码。Khronos 发行了他们的制造商无关的编译器,能够将 GLSL 编译为 SPIR-V 格式。该编译器能验证着色器代码符合标准,并生成 SPIR-V 二进制供你的程序使用。你也可以将这个编译期作为库引入你的程序,这样就能在运行时编译着色器代码了,不过在本教程中我们不这么做。

尽管我们可以直接通过 glslangValidator.exe 使用这个编译器,本教程中我们会使用由 Google 开发的 glslc.exe。glslc 的优势在于它与 GCC 和 Clang 这样的广为人知的编译器使用相同的命令行参数格式,并且支持一些额外的功能,例如 #include。这两个编译器都包含在 Vulkan SDK 中,所以你不需要额外下载任何东西。

GLSL 是一种使用类 C 语法的着色器语言。使用 GLSL 编写的程序包含了一个 main 函数,这一函数完成具体的运算操作。GLSL 使用全局变量进行输入输出,而不是使用参数和返回值。GLSL 语言本身包含了许多用于图形编程的特性,例如内建的向量和矩阵类型,用于叉乘和矩阵乘法的函数,以及用于计算反射向量的函数。

在 GLSL 中,向量类型使用 vec 加上一个表示向量元素的数字来命名。例如,一个三维空间中的位置可以用 vec 存储。可以通过 .x 这样的字段访问向量的单个分量,也可以通过一次性指定多个分量来创建一个新的向量。例如,表达式 vec3(1.0, 2.0, 3.0).xy 的结果是 vec2。向量的构造函数可以接受向量对象和标量值的组合。例如,可以使用 vec3(vec2(1.0, 2.0), 3.0) 来构造一个 vec3。

如我们在之前的章节中所提到的,要绘制一个三角形,我们需要编写一个顶点着色器和一个片元着色器。接下来的两节中我们会分别介绍这两个着色器的 GLSL 代码,之后我们会展示如何生成两个 SPIR-V 二进制文件,并将它们加载到程序中。

顶点着色器

顶点着色器处理每个传入的顶点。它以顶点的属性 —— 例如世界坐标、颜色、法线和纹理坐标 —— 作为输入,输出最终的裁剪坐标(clip coordinates)和需要传递给片元着色器的属性,例如颜色和纹理坐标。这些值将由光栅化器(rasterizer)在片元上进行插值,从而产生平滑的渐变。

裁剪坐标是一个顶点着色器输出的四维向量,它的四个分量会被除以第四个分量,从而产生一个标准化设备坐标(normalized device coordinate)。这些归一化设备坐标是 齐次坐标(homogeneous coordinates),它将帧缓冲映射到一个 [-1, 1] × [-1, 1] 的坐标系中,如下图所示:

如果你之前涉足过计算机图形学,你应该不会对这些东西感到陌生。而如果你曾使用过 OpenGL,那么你会注意到这里的 Y 轴和 OpenGL 是相反的,而 Z 轴则使用和 Direct3D 相同的范围,即从 0 到 1。

对于我们的第一个三角形,我们不会应用任何变换,而是直接指定三个顶点的标准化设备坐标,从而创建如下图所示的形状:

我们可以直接从顶点着色器输出标准化设备坐标 —— 只需要通过裁剪坐标将它们从顶点着色器输出,并将最后一个分量设置为 1,这样,将裁剪坐标转换为标准化设备坐标的除法就不会改变任何东西。

通常情况下,这些坐标应该存储在顶点缓冲(vertex buffer)中,但在 Vulkan 中创建并填充顶点缓冲并不是什么轻松的事。为了尽快让我们看到三角形,我们暂时将这些坐标直接包含在顶点着色器中。代码如下:

#version 450

vec2 positions[3] = vec2[](

vec2(0.0, -0.5),

vec2(0.5, 0.5),

vec2(-0.5, 0.5)

);

void main() {

gl_Position = vec4(positions[gl_VertexIndex], 0.0, 1.0);

}

main 函数会对每个顶点执行一次。GLSL 内建的 gl_VertexIndex 中存储了当前顶点的索引,这一索引通常是用来引用顶点缓冲中顶点数据的,不过这里我们用它来索引一个硬编码的顶点数据数组。每个顶点的位置从着色器中的常量数组中获取,并与 z 和 w 分量组合,从而产生一个裁剪坐标。最后,我们将顶点的位置通过 gl_Position 内建变量输出。

片元着色器

由顶点着色器输出的顶点位置组成的三角形将会填充屏幕上一定范围内片元。片元着色器会对每个片元运行,输出帧缓冲上对应位置的颜色和深度。一个简单的将整个三角形填充为红色的片元着色器如下所示:

#version 450

layout(location = 0) out vec4 outColor;

void main() {

outColor = vec4(1.0, 0.0, 0.0, 1.0);

}

类似于顶点着色器的 main 函数,片元着色器的 main 函数会对每个片元执行一次。GLSL 中的颜色是一个四维向量,四个分量分别对应 R、G、B 和 alpha 四个通道,每个分量的取值范围都是 [0, 1]。不同于顶点着色器中的 gl_Position,片元着色器中没有用于输出颜色的内建变量。你必须为每个帧缓冲指定一个输出变量,并用layout 指定帧缓冲的索引。这里,我们将红色写入到 outColor 变量中,这一变量与索引为 0 的帧缓冲(也是唯一的帧缓冲)绑定。

逐顶点着色

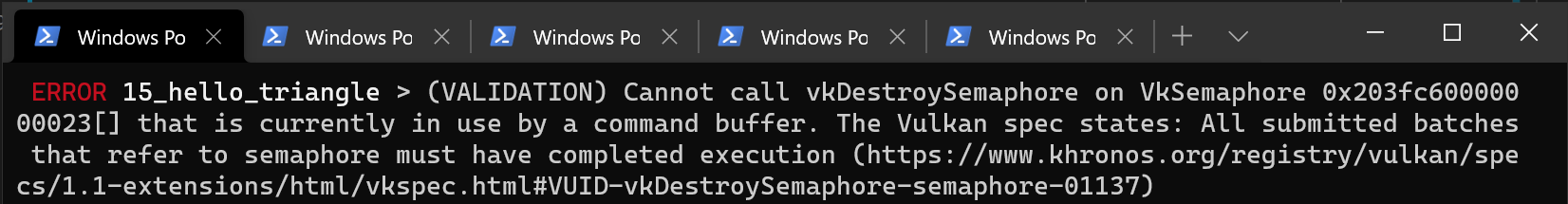

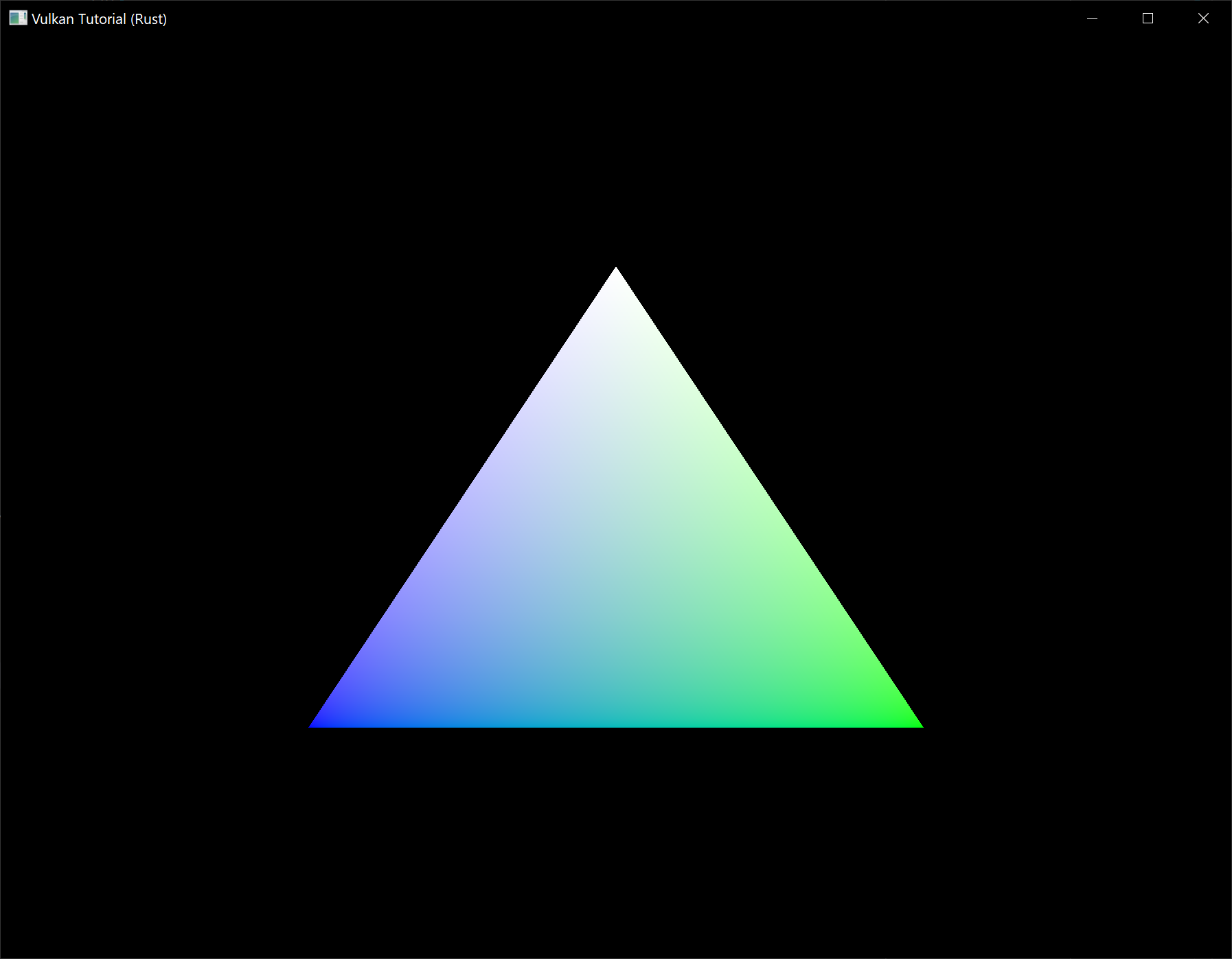

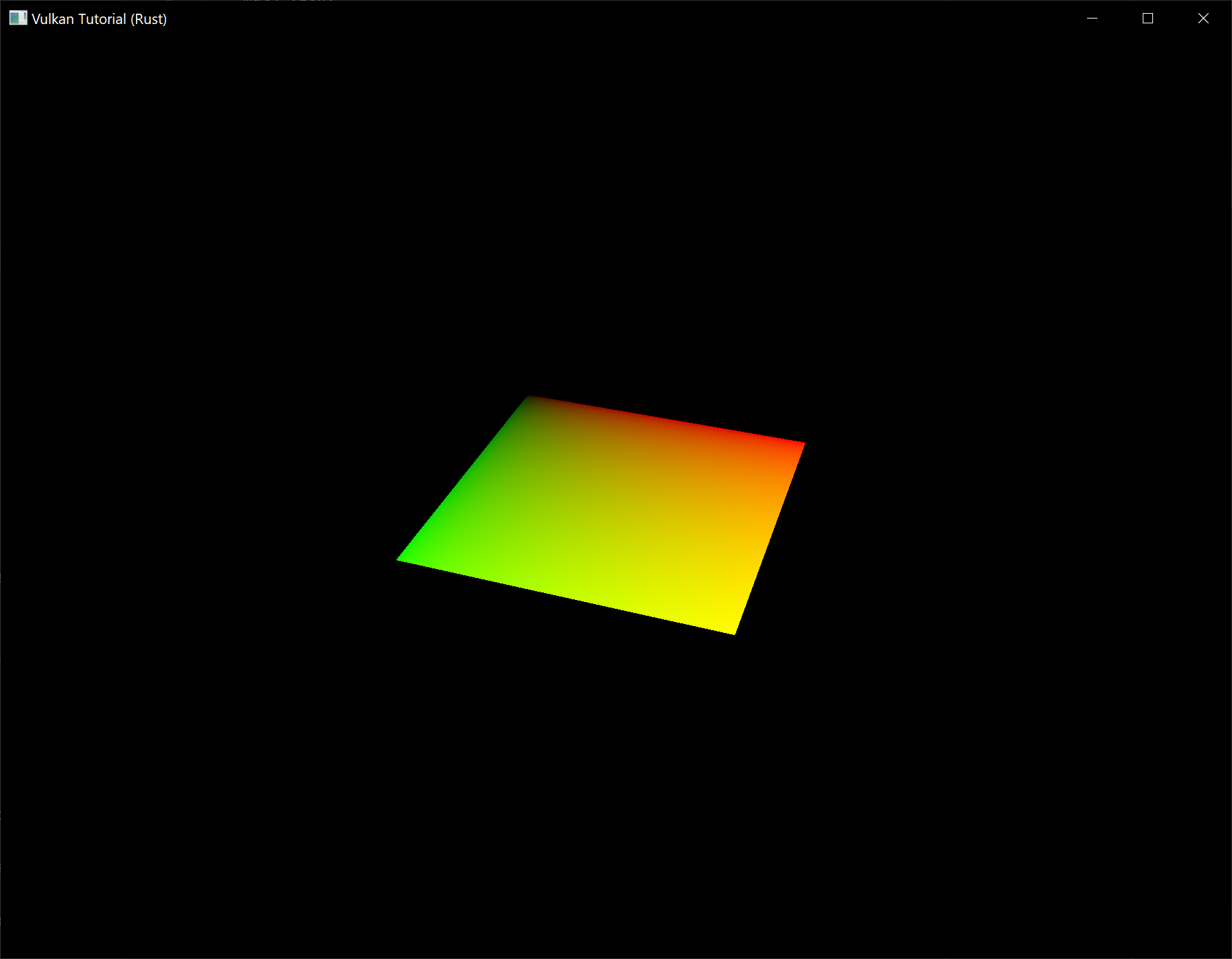

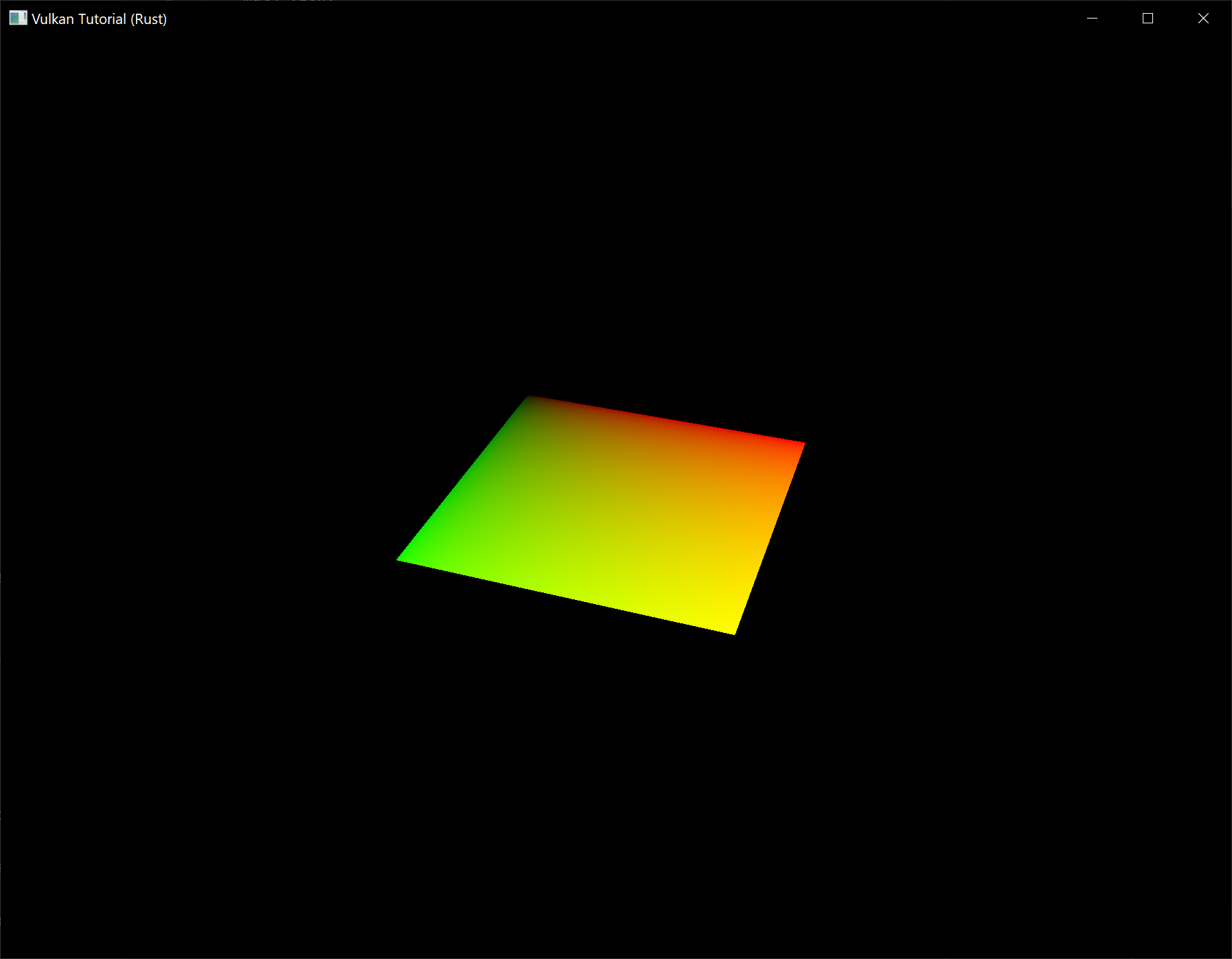

整个三角形都是红色,一点都不好玩。你不觉得下面这样看起来更有趣吗?

我们修改一下两个着色器来实现这个效果。首先,我们为每个顶点指定各自的颜色。在顶点着色器中加入这样一个颜色数组:

vec3 colors[3] = vec3[](

vec3(1.0, 0.0, 0.0),

vec3(0.0, 1.0, 0.0),

vec3(0.0, 0.0, 1.0)

);

接着,我们将这些顶点的颜色传递给片元着色器,片元着色器就能将插值后的颜色输出到帧缓冲。在顶点着色器中添加一个颜色输出变量,并在 main 函数中写入它:

layout(location = 0) out vec3 fragColor;

void main() {

gl_Position = vec4(positions[gl_VertexIndex], 0.0, 1.0);

fragColor = colors[gl_VertexIndex];

}

接着,我们在片元着色器中加入一个对应的输入变量:

layout(location = 0) in vec3 fragColor;

void main() {

outColor = vec4(fragColor, 1.0);

}

这个输入变量不一定要和顶点着色器中的输出变量使用相同的颜色,因为它们会根据 location 指令指定的索引被链接到一起。main 函数现在它会输出从 fragColor 读取的颜色和 alpha 值。如上图所示,fragColor 的值会自动在三个顶点之间进行插值,从而产生平滑的渐变。

编译着色器

在你工程的根目录里创建一个名为 shader 的文件夹(与 src 文件夹相邻),并将顶点着色器保存到 shader.vert 文件中,将片元着色器保存到 shader.frag 文件中。GLSL 着色器没有官方的文件扩展名,但是 .vert 和 .frag 这两个扩展名比较常用。

shader.vert 的内容如下:

#version 450

layout(location = 0) out vec3 fragColor;

vec2 positions[3] = vec2[](

vec2(0.0, -0.5),

vec2(0.5, 0.5),

vec2(-0.5, 0.5)

);

vec3 colors[3] = vec3[](

vec3(1.0, 0.0, 0.0),

vec3(0.0, 1.0, 0.0),

vec3(0.0, 0.0, 1.0)

);

void main() {

gl_Position = vec4(positions[gl_VertexIndex], 0.0, 1.0);

fragColor = colors[gl_VertexIndex];

}

而 shader.frag 的内容如下:

#version 450

layout(location = 0) in vec3 fragColor;

layout(location = 0) out vec4 outColor;

void main() {

outColor = vec4(fragColor, 1.0);

}

接下来,我们使用 glslc 程序将这些着色器编译为 SPIR-V 字节码。

Windows

创建一个包含以下命令的 compile.bat 文件:

C:/VulkanSDK/x.x.x.x/Bin32/glslc.exe shader.vert -o vert.spv

C:/VulkanSDK/x.x.x.x/Bin32/glslc.exe shader.frag -o frag.spv

pause

把 glslc.exe 的路径替换为你安装 Vulkan SDK 的路径,双击这个文件来运行它。

Linux

创建一个包含以下命令的 compile.sh 文件:

/home/user/VulkanSDK/x.x.x.x/x86_64/bin/glslc shader.vert -o vert.spv

/home/user/VulkanSDK/x.x.x.x/x86_64/bin/glslc shader.frag -o frag.spv

将 glslc 的路径替换为你安装 Vulkan SDK 的路径。使用 chmod +x compile.sh 命令将这个脚本变得可执行,然后运行它。

MacOS

创建一个包含以下命令的 compile.sh 文件:

/User/user/VulkanSDK/x.x.x.x/macOS/bin/glslc shaders/shader.vert -o vert.spv

/User/user/VulkanSDK/x.x.x.x/macOS/bin/glslc shaders/shader.frag -o frag.spv

这两条命令告诉编译器从 GLSL 源文件中读取代码,并输出一个 SPIR-V 字节码文件。

如果你的着色器代码中有语法问题,编译器会告诉你问题所在。你可以试着故意遗漏一个逗号然后重新运行编译脚本。

你也可以在不带任何参数的情况下运行编译器,这样就能看到它支持的命令行参数。例如,它可以输出人类可读的字节码,这样你就能看到你的着色器在做什么,以及编译器对它做了哪些优化。

用命令行编译着色器是比较直观的方式,本教程中我们会一直沿用这种方式,不过你也可以在你的应用程序中直接编译着色器。Vulkan SDK 包含了 libshaderc,它是一个库,你的程序可以用它在运行时直接将 GLSL 代码编译为 SPIR-V 字节码。

加载着色器

现在我们有了创建 SPIR-V 着色器的方式,是时候把它们引入我们的程序中,并插入渲染管线了。我们会使用 Rust 标准库中的 include_bytes! 宏来将编译后的 SPIR-V 字节码包含进我们的程序中:

unsafe fn create_pipeline(device: &Device, data: &mut AppData) -> Result<()> {

let vert = include_bytes!("../shaders/vert.spv");

let frag = include_bytes!("../shaders/frag.spv");

Ok(())

}创建着色器模块

我们需要将着色器代码包装在一个 vk::ShaderModule 对象中才能将其传递给管线。让我们创建一个辅助函数 create_shader_module 来完成这一工作: